音乐添加方法、装置、计算机设备及计算机可读存储介质与流程-j9九游会真人

1.本技术涉及音视频处理技术领域,具体涉及一种音乐添加方法、装置、计算机设备及计算机可读存储介质。

背景技术:

2.在不同的应用场景下的虚拟场景中,虚拟对象一般是通过简单的对话进行互动。因此,虚拟场景中的互动方式单一,难以表达虚拟对象更多的互动情绪,表达效果差。

3.随着多媒体技术的不断发展,在对观看的视频进行剪辑时往往会添加一些背景音乐增强视频内容的表达效果。因此,可以在虚拟场景中添加背景音乐以增强虚拟场景中虚拟对象进行互动的表达效果。

4.然而,在相关技术中,添加背景音乐的方式往往是通过人工剪辑的方式对多媒体音视频进行剪辑的过程中手动添加背景音乐。该手动添加音乐的方式的自动化低。

技术实现要素:

5.本技术实施例提供一种音乐添加方法、装置、计算机设备及计算机可读存储介质,可以提高添加音乐的自动化。

6.第一方面,本技术公开一种音乐添加方法,包括:

7.获取虚拟场景中的对话音频片段;

8.确定所述对话音频片段的情绪类型;

9.将所述对话音频片段转换为文字文本,得到对话文本内容;

10.计算第一关键词与所述情绪类型对应关键词表中每个关键词之间的相似度得到多个相似度得分,所述第一关键词为所述对话文本内容中的任一关键词;

11.在所述多个相似度得分中存在相似度得分大于或等于预设相似度阈值的情况下,识别所述第一关键词的情绪意图;

12.获取所述情绪意图对应的背景音乐;

13.在所述对话音频片段中添加所述背景音乐。

14.第二方面,本技术公开一种音效添加装置,包括:

15.第一获取单元,用于获取虚拟场景中的对话音频片段;

16.第一确定单元,用于确定所述对话音频片段的情绪类型;

17.转换单元,用于将所述对话音频片段转换为文字文本,得到对话文本内容;

18.计算单元,用于计算第一关键词与所述情绪类型对应关键词表中每个关键词之间的相似度得到多个相似度得分,所述第一关键词为所述对话文本内容中的任一关键词;

19.识别单元,用于在所述多个相似度得分中存在相似度得分大于或等于预设相似度阈值的情况下,识别所述第一关键词的情绪意图;

20.第二获取单元,用于获取所述情绪意图对应的背景音乐;

21.添加单元,用于在所述对话音频片段中添加所述背景音乐。

22.在一些实施例中,所述第一确定单元具体用于:

23.基于情绪检测模型提取所述对话音频片段的音频属性特征;

24.根据所述音频属性特征,确定所述对话音频片段的情绪类型。

25.在一些实施例中,所述音效添加装置还包括:

26.提取单元,用于在所述对话文本内容中提取所述第一关键词;

27.第三获取单元,用于获取所述情绪类型对应的关键词表。

28.在一些实施例中,所述计算单元具体用于:

29.计算所述第一关键词的第一词汇向量;

30.计算第二关键词的第二词汇向量,所述第二关键词为所述情绪类型对应关键词表中的任一关键词;

31.基于余弦距离公式计算所述第一词汇向量与所述第二词汇向量之间的相似度得分,得到多个相似度。

32.在一些实施例中,所述识别单元,具体用于将第一关键词输入意图识别模型,得到所述第一关键词对应的情绪意图,所述关键词与情绪意图的对应关系根据预设的应用场景设置。

33.在一些实施例中,所述第二获取单元,具体用于从所述情绪意图对应的音频数据库中选择背景音乐。

34.在一些实施例中,所述添加单元具体用于:

35.检测所述对话音频片段中存在的静音片段;

36.确定所述静音片段的静音时长;

37.在所述静音时长超过预设阈值的情况下,在所述静音片段添加所述背景音乐。

38.在一些实施例中,所述音效添加装置,还包括:

39.第四获取单元,用于获取第一播放音量,所述第一播放音量为所述对话音频片段的播放音量;

40.第二确定单元,用于根据所述第一播放音量确定第二播放音量,所述第二播放音量为所述背景音乐的播放音量;

41.播放单元,用于根据所述第二播放音量播放所述背景音乐。

42.第三方面,本技术公开一种计算机设备,包括存储器、处理器以及存储在所述存储器中并可以在所述处理器上运行的计算机程序,所述处理器执行所述计算机程序时实现上述第一方面公开的方法。

43.第四方面,本技术公开一种计算机存储介质,所述存储介质存储有多条指令,所述指令适于处理器进行加载,以执行上述音乐添加方法中的步骤。

44.第五方面,本技术公开了一种计算机程序产品,该计算机程序产品包括计算机程序代码,当该计算机程序代码被处理器运行时,使得上述音乐添加方法被执行。

45.本技术实施例中,获取虚拟场景中的对话音频片段;确定对话音频片段的情绪类型;将对话音频片段转换为文字文本,得到对话文本内容;计算第一关键词与情绪类型对应关键词表中每个关键词之间的相似度得到多个相似度得分,该第一关键词为所述对话文本内容中的任一关键词;在多个相似度得分中存在相似度得分大于或等于预设相似度阈值的情况下,识别第一关键词的情绪意图;获取情绪意图对应的背景音乐;在对话音频片段中添

加背景音乐。由于自动对音视频流中的对话音频片段进行情绪识别,确定情绪类型后根据情绪类型对应的关键词表对对话音频片段进行意图识别,确定该对话音频片段对应的情绪意图,并根据该情绪意图选择相应的背景音乐,再自动将该背景音乐添加至虚拟场景的对话音频片段中,提高了在虚拟场景的对话片段中添加背景音乐的自动化。此外,通过自动化高的背景音乐添加方式减少了对话音频处理的成本。

附图说明

46.为了更清楚地说明本技术实施例中的技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本技术的一些实施例,对于本领域技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

47.图1是本技术实施例公开的一种系统的架构示意图;

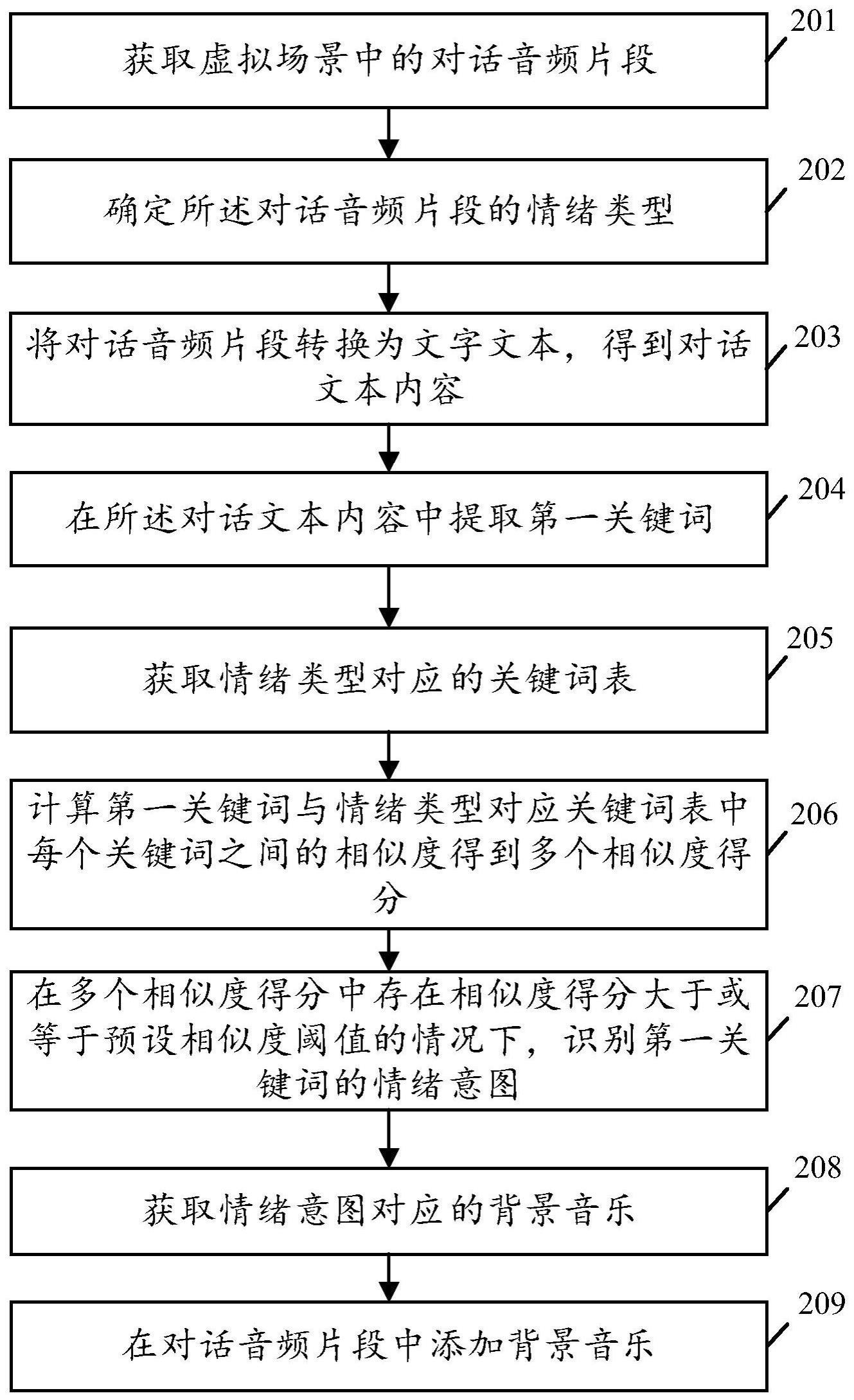

48.图2是本技术实施例公开的一种音乐添加方法的流程示意图;

49.图3是本技术实施例公开的步骤202的具体流程示意图;

50.图4是本技术实施例公开的另一种音乐添加方法的流程示意图;

51.图5是本技术实施例公开的一种音乐添加装置的结构示意图;

52.图6是本技术实施例公开的一种计算机设备的结构示意图;

53.图7是本技术实施例公开的一种计算机可读存储介质的结构示意图。

具体实施方式

54.下面详细描述本技术的实施方式,实施方式的示例在附图中示出,其中自始至终相同或类似的标号表示相同或类似的元件或具有相同或类似功能的元件。下面通过参考附图描述的实施方式是示例性地,仅用于解释本技术,而不能理解为对本技术的限制。

55.为了使本技术领域的人员更好地理解本技术的方案,下面将结合本技术实施例中的附图,对本技术实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本技术一部分实施例,而不是全部的实施例。基于本技术中的实施例,本领域技术人员在没有作出创造性劳动前提下所获得的所有其他实施例,都属于本技术保护的范围。

56.随着虚拟现实技术的发展,在不同的应用场景下的虚拟场景中,虚拟对象一般是通过简单的对话进行互动。因此,虚拟场景中的互动方式单一,难以表达虚拟对象更多的互动情绪,表达效果差。随着多媒体技术的发展,视频的趣味性要求不断提高,往往会在音视频流中添加背景音乐以增强视频内容的表达效果。因此,可以在虚拟场景中添加背景音乐,增加虚拟对象表达互动情绪的互动方式,增强虚拟场景中虚拟对象进行互动的表达效果。

57.然而,在多媒体领域中对视频添加音乐的方式往往是在人工剪辑的过程中手动添加背景音乐。因此,现有的音效添加方式过度依赖专业剪辑人员,自动化低。而将该自动化低的音乐添加方式应用于虚拟场景中对话片段的背景音乐添加,导致虚拟场景的对话音频处理的成本高。

58.为了解决上述问题,本技术实施例中,获取虚拟场景中的对话音频片段;确定所述对话音频片段的情绪类型;将对话音频片段转换为文字文本,得到对话文本内容;计算第一关键词与情绪类型对应关键词表中每个关键词之间的相似度得到多个相似度得分;在多个

相似度得分中存在相似度得分大于或等于预设相似度阈值的情况下,识别第一关键词的情绪意图;获取情绪意图对应的背景音乐;在对话音频片段中添加背景音乐。

59.通过在虚拟场景中的对话音频片段中加入背景音乐,增加虚拟场景中的互动方式,表达虚拟场景中虚拟对象更多的互动情绪,提升虚拟场景中的表达效果。并在虚拟场景中的对话片段中自动添加背景音乐,提高了在虚拟场景的对话片段中添加背景音乐的自动化。此外,通过自动化高的背景音乐添加方式,减少了虚拟场景中对话音频处理的成本。

60.为了更好地理解本技术实施例,下面先对本技术的系统架构图进行介绍。

61.请参阅图1,图1是本技术实施例公开的一种系统100的架构示意图。如图1所示,该系统架构可以包括虚拟终端110、处理器120和存储器130。该虚拟终端110与该处理器可以通过通信网络连接,实现数据的双向传输。该处理器120与该存储器130可以通过通信网络连接,实现数据的双向传输。该通信网络可以包括无线网络和/或有线网络。无线网络可以包括无线广域网、无线局域网、无线城域网、无线个人网等无线网络中的一种或多种。上述网络可以包括路由器、网关等网络实体,图中并未示意出。

62.其中,虚拟终端110可以是手机客户端、虚拟交互端等用于虚拟交互的设备终端。该虚拟终端110可以应用于虚拟会议场景、虚拟课堂场景、虚拟销售场景、虚拟直播场景等虚拟互动场景。该虚拟终端110可以将获取到的虚拟场景中的对话音频片段传输至处理器120。

63.处理器120可以用于处理虚拟终端110以及存储器130中的数据,以及控制虚拟终端110和存储器130。该处理器120可以集成在平板电脑、手机、笔记本电脑、台式电脑等具备计算单元并安装有处理器而具有运算能力的终端设备中。

64.存储器130可以用于存储音频属性信息与情绪类型的对应关系,该音频属性信息可以包括音频的声调和音量等信息。该存储器130还可以用于存储情绪类型及其对应的关键词表,每一情绪类型都对应存在一个关键词表,该关键词表中包含多个能够表达该情绪类型的关键词。该存储器130还可以用于存储情绪意图与音频数据库的对应关系,该音频数据库中包含多个能够表征该情绪意图的背景音乐。

65.作为一种实施方式,在自动对实时音视频流添加音乐时,虚拟终端110获取虚拟场景中的对话音频片段,并将该对话音频片段传输给处理器120。处理器120确定该对话音频片段的情绪类型,调用存储器130中与该情绪类型对应的关键词表,并计算对话音频片段对应的对话文本内容中的关键词与关键词表中的每一关键词的相似度得分,根据该相似度得分确定该关键词的情绪意图,再调用存储器130中与该情绪意图对应的音频数据库,在该情绪意图对应的音频数据库中选择背景音乐添加到对话音频片段中。

66.需要说明的是,图1所示的系统架构示意图仅仅是一个示例,本技术实施例描述的系统以及场景是为了更加清楚的说明本技术实施例的技术方案,并不构成对于本技术实施例提供的技术方案的限定。本领域普通技术人员可知,随着对话音频处理的演变和新业务场景的出现,本技术实施例提供的技术方案对于类似的技术问题,同样适用。

67.请参阅图2,图2是本技术实施例公开的一种音乐添加方法的流程示意图。其中,该音乐添加方法可以应用于搭载音乐添加方法的终端中。该音乐添加方法可以包括以下步骤。

68.201、获取虚拟场景中的对话音频片段。

69.该终端可以连接虚拟交互设备。该虚拟交互设备可以用于录制和/或生成虚拟场景中虚拟对象的对话音频。示例性地,在虚拟直播场景中,虚拟交互设备可以包括音频录制装置和音频生成装置。通过该音频录制装置录制主播a的实时音频1,该主播a可以是虚拟交互设备的录制对象。通过该音频生成装置生成主播b的实时音频2,该主播b可以是虚拟交互设备的生成对象。主播a和主播b在该虚拟直播场景中进行对话,相应地,实时音频1与实时音频2组成在虚拟直播场景中的对话音频。

70.该终端与虚拟交互设备连接,可以以非离线的方式实时获取虚拟场景中虚拟对象的对话音频。该对话音频可以是虚拟场景中虚拟对象进行对话的整段音频。该整段音频可以是包含多个虚拟对象进行对话的多段对话音频,可以在该整段音频中选取虚拟对象进行对话的对话音频片段。该对话音频片段用于进行后续的情绪识别和意图检测,并通过关键词检测匹配对应的背景音乐。

71.具体地,在整段音频中选取对话音频片段可以在整段音频中按照预设音频长度选取对话音频片段;也可以是在整段音频中的多段对话音频中按照预设对话段数选取对话音频片段;还可以是在实时接收到的整段音频中静音时长不超过预设时长的对话音片段。

72.202、确定所述对话音频片段的情绪类型。

73.该终端还可以包括情绪检测模型。该情绪检测模型可以用于根据该对话音频片段,确定在虚拟场景中进行对话的虚拟对象的情绪类型。可理解地,现实场景中的说话人在进行对话时,可以在语气中夹杂语音、语调等音频属性特征来表征说话人在对话时的情绪。而在虚拟场景下,录制和/或生成的对话音频也可以通过不同的语音、语调和音量等音频属性特征来表征虚拟场景中虚拟对象的情绪。相应的,在虚拟场景下的对话音频片段也可以通过不同的语音、语调和音量等音频属性特征表达虚拟对象在进行该段对话时的情绪类型。

74.在确定对话音频片段的情绪类型之前,可以设置情绪检测模型中语音、语调和音量等音频属性特征与虚拟对象的情绪类型的对应关系。该对应关系用于根据音频属性特征匹配对应的虚拟对象的情绪类型。

75.对话音频片段是实时获取的虚拟场景中的整段对话音频中的片段,该对话音频片段中可以包含一种或多种情绪类型。具体地,对话音频片段中可以包括虚拟场景中多个虚拟对象的音频。而每个虚拟对象的音频可以是相同或不同的音频属性特征,该音频属性特征可以是一种或多种语音、语调和音量等信息的组合。根据该音频属性特征,确定在进行该对话音频片段时虚拟对象的情绪类型。

76.在一些实施方式中,可以通过情绪检测模型提取对话音频片段的音频属性特征。

77.该情绪检测模型可以对音频属性特征进行模型编码,在对话音频片段中提取对应的音频属性特征。具体地,该情绪检测模型包括但不限于长短期记忆网络(long short-term memory,lstm)、隐马尔可夫模型(hidden markov model,hmm)等学习网络。该情绪检测模型可以是基于预设标签数据集训练好的对话音频片段三分类模型。该对话音频片段三分类模型可以用于对话音频片段的情绪分类,并得到对应的情绪分类结果,该情绪分类结果可以包括积极、平稳和消极。

78.对话音频片段是音频数据,而音频数据都存在对应的音频频谱。可以根据对话音频片段对应的音频频谱确定对话音频片段中的音频属性特征。示例性地,该情绪检测模型

可以根据对话音频片段对应的音频频谱,提取到对应的频谱特征。该频谱特征可以包括短时过零率、短时能量、短时自相关函数、短时平均幅度、频谱差分幅度、频谱质心和频谱宽度。进一步地,根据该频谱特征确定对话音频片段对应的音频属性特征。该音频属性特征包括语音、语调和音量等信息。

79.该情绪检测模型还可以根据音频属性特征,确定对话音频片段的情绪类型。可以对音频属性特征进行模型解码,在该情绪检测模型中匹配与该音频属性特征对应的情绪类型。

80.请参阅图3,图3是本技术实施例公开的步骤202的具体流程示意图。如图3所示,对话在输入语音处理系统,根据对话的语音的物理量(音高、音量)进行特征提取,得到对话的分类成分(音频属性特征),并根据该分类成分确定对应的情绪类型。

81.203、将对话音频片段转换为文字文本,得到对话文本内容。

82.该终端还可以包括文本转换模型。该文本转换模型可以用于将对话音频片段从音频信息转换为文本文字。可以在获取虚拟场景中整段实时的对话音频时,实时将该整段的对话音频转换为对应的文字文本。还可以在获取整段的对话音频中的对话音频片段时,将每一段对话音频片段转换为对应的文字文本。本技术实施例对音频转换为文本的时间点不做限制。

83.204、在所述对话文本内容中提取第一关键词。

84.该对话文本内容可以包括虚拟对象对话的多个关键词。上述多个关键词可以对应不同的情绪类型。由于在上述步骤中优先检测对话音频片段的情绪类型。因此,可以选取该对话文本中与情绪类型对应的关键词作为第一关键词。

85.示例性地,识别对话音频片段1的情绪类型为“消极”。对话音频片段1对应的对话文本内容1为“哈哈,我的天哪”。提取“哈哈,我的天哪”中与“消极”对应的关键词,可以得到在该对话文本内容1中的第一关键词为“我的天哪”。

86.205、获取情绪类型对应的关键词表。

87.在该终端的存储器中,可以存储有每一情绪类型对应的关键词表。该关键词表中可以包括多个关键词,关键词表中的每个关键词都可以属于关键词表对应的情绪类型。

88.该关键词表可以是基于哈希算法对样本数据进行分类,可以是以哈希字典的形式存在。具体地,通过对样本数据进行分类标注创建哈希字典,该哈希字典中包括按照不同的情绪类型对关键词进行分类标注的情绪类型和情绪类型对应的关键词集合。该以哈希字典存在的关键词表中可以将情绪类型作为属性键,将关键词集合作为键值。相比于其他的分类标注方法,基于哈希算法分类标注得到的关键词表的情绪类型的分类结果更加准确,且在后续关键词表的查询过程中,查询结果更加精准。

89.在先确定对话音频片段的情绪类型的状况下,可以将检测到的对话音频片段的情绪类型作为索引,在关键词表中查询出属性键为该情绪类型的关键词,并将该属性键(情绪类型)对应的每个关键词作为关键词表。该关键词表中可以包括多个与该情绪类型对应的关键词。

90.206、计算第一关键词与情绪类型对应关键词表中每个关键词之间的相似度得到多个相似度得分。

91.在获取对话文本内容中的第一关键词以及情绪类型对应的关键词表后,可以计算

第一关键词与关键词表中每个关键词的相似度,得到第一关键词与关键词表中每个关键词的相似度得分。

92.第一关键词与关键词表中关键词的相似度可以通过将第一关键词的第一词汇向量以及与情绪类型对应关键词表中的任一关键词的第二词汇向量输入余弦距离公式,确定在n维空间中两个n维词汇向量(第一词汇向量和第二词汇向量)之间角度的余弦,并根据计算得到的余弦的值确定该两个词汇向量之间的相似度得分。其中,第一词汇向量和第二词汇向量可以是词频向量,词频向量可以表达关键词中每个字符串的在关键词中出现的频率。

93.第二关键词为情绪类型对应关键词表中的任一关键词,关键词表中可以包含多个第二关键词。因此,可以计算多次第一词汇向量和第二词汇向量的相似度,相应地得到多个相似度得分。

94.示例性地,第一关键词“我的天哪!”;关键词表中的第二关键词“我的神啊啊!”,在列出两个关键词中每个字符后计算每个字符在当前关键词中出现的词频,分别得到第一词汇向量为(2,2,1,0,2,0,0,0,1),第二词汇向量为(2,2,1,2,2,2,0,0,1)。通过对第一词汇向量和第二词汇向量进行相似度计算,确定这两个向量在多维空间中的相似程度。

95.可理解地,第一词汇向量和第二词汇向量之间形成夹角。因此,在该夹角为0度的情况下,说明第一词汇向量和第二词汇向量的方向相同、线段重合,这表明这两个向量代表的文本完全相同。在该夹角为90度的情况下,说明两个词汇向量形成直角,方向完全不相似。在该夹角为180度的情况下,说明两个词汇向量的方向刚好相反。

96.根据两个词汇向量之间的夹角可以确定对应两个关键词的相似度。根据两个关键词对应的两个词汇向量之间的夹角可以计算对应的夹角余弦值。该夹角余弦值可以用于表示两个词汇向量对应的关键词之间的相似度。夹角余弦值的范围为[-1,1],在夹角余弦值(相似度得分)为-1的情况下,两个词汇向量对应的关键词完全不同;在夹角余弦值(相似度得分)为1的情况下,两个词汇向量对应的关键词完全相同。

[0097]

207、在多个相似度得分中存在相似度得分大于或等于预设相似度阈值的情况下,识别第一关键词的情绪意图。

[0098]

在判断出关键词表中存在相似度得分大于或等于预设相似度阈值的关键词的情况下,说明第一关键词与该情绪类型对应的关键词表中的一些关键词达到预设的相似度。由于相似度得分可以是两个词汇向量的夹角余弦值,该夹角余弦值的范围为[-1,1]。因此,上述预设相似度阈值可以是在夹角余弦值的范围[-1,1]内选取的夹角余弦阈值。

[0099]

示例性地,可以选取0.8作为预设相似度阈值。在预设相似度阈值为0.8的情况下,只有当第一关键词与关键词表中的第二关键词对应的两个词汇向量之间的夹角余弦值不小于0.8时,才满足两个关键词的相似度得分大于或等于预设相似度阈值。

[0100]

在判断出关键词表中不存在相似度得分大于或等于预设阈值的关键词的情况下,即在关键词表中每个关键词与第一关键词的相似度得分都小于预设阈值。说明第一关键词与关键词列表中的每个关键词虽然在音频属性特征方面属于同一种情绪类型,但第一关键词的字符串却并未与该情绪类型对应的关键词表中的任一个关键词达到预设的相似度。此时对该对话音频片段不执行后续的步骤,提示开发人员判断该对话音频片段中的第一关键词的字符串是否应该加入关键词表,更新情绪类型对应的关键词表。

[0101]

在关键词表中存在一个或多个关键词与第一关键词的相似度得分达到预设相似度阈值的情况下,说明该第一关键词命中了关键词表中一个或多个第二关键词。可以对该第一关键词进行意图识别,得到第一关键词的情绪意图。该第一关键词的情绪意图可以用于表达第一关键词所在的对话音频片段虚拟对象的情绪意图。

[0102]

识别第一关键词的情绪意图的方式可以是将第一关键词输入意图识别模型,得到第一关键词对应的情绪意图。第一关键词为多个相似度得分大于或等于预设阈值对应的任一关键词。

[0103]

该情绪意图可以根据关键词与情绪意图的对应关系进行匹配,得到该第一关键词的情绪意图。关键词与情绪意图的对应关系根据预设的应用场景设置,预设的应用场景可以根据虚拟场景具体的应用场景设置。

[0104]

例如,虚拟场景具体的应用场景可以包括虚拟会议场景、虚拟课堂场景、虚拟销售场景、虚拟直播场景等。针对不同的应用场景,可以预先设置不同的情绪意图分类。进一步地,针对相同的具体的应用场景,可以包括不同主题、不同类别,针对不同主题、不同类别的具体的应用场景又可以对情绪意图进行分类细化。对于不用的应用场景,以及应用场景的主题、类别等不做具体限定,相应的,应用场景与不同主题、类别的应用场景与情绪意图的对应关系也不做具体的限定。

[0105]

208、获取情绪意图对应的背景音乐。

[0106]

情绪意图作为意图识别的识别结果,可以作为检索关键词搜索相应的音频数据库。该音频数据库可以是根据预先设置的情绪意图对应设置的,该音频数据库中可以包括用于表征该情绪意图的背景音乐(background music,bgm)。该背景音乐可以是具有播放时长、播放音量等音频播放属性的背景音乐。

[0107]

获取情绪意图对应的背景音乐可以从情绪意图对应的音频数据库中选择背景音乐。选择背景音乐的方式可以随机选择音频数据库中的背景音乐。也可以根据背景音乐的播放时长、播放音量等音频播放属性,在音频数据库中选择播放时长、播放音量等音频播放属性达到相应的音频播放标准的背景音乐。

[0108]

示例性地,在第一关键词的情绪意图是“震惊”的情况下,用情绪意图“震惊”作为关键词,在“震惊”对应的音频数据库中随机选择一首背景音乐。

[0109]

209、在对话音频片段中添加背景音乐。

[0110]

在一种情况下,可以根据背景音乐的播放时长、播放音量等音频播放属性,在音频数据库中选择播放时长、播放音量等音频播放属性达到相应标准的背景音乐。

[0111]

在另一种情况下,可以在音频数据库中随机选择背景音乐,该背景音乐用于添加至待添加背景音乐的对话音频片段。该随机选择的背景音乐可能与待添加背景音乐的对话音频片段并不适配。因此,需要检测待添加背景音乐的对话音频片段的音频播放属性,在待添加背景音乐的对话音频片段的音频播放属性达到相应标准的情况下,在对话音频片段中添加背景音乐。

[0112]

检测待添加背景音乐的对话音频片段的音频播放属性可以包括:检测对话音频片段中存在的静音片段;确定静音片段的静音时长;在静音时长超过预设阈值的情况下,在该静音片段添加背景音乐。

[0113]

需要说明的是,在背景音乐的音乐时长小于或等于待添加背景音乐的对话音频片

段的静音片段的情况下,背景音乐才能够添加至对话音频片段。该对话音频片段中存在的静音片段可以是在整段对话音频中对话音频片段的对话间隔部分,也可以是对话音频片段中播放音量不超过预设音量的音频部分。在上述静音片段的静音时长超过预设阈值的情况下,在虚拟场景中的对话音频中添加对应的背景音乐。

[0114]

以此,通过在各种不同应用场景下的虚拟场景的对话音频片段中自动添加背景音乐,增加虚拟场景中对话互动方式的多样性,提升虚拟场景中对话音频片段的表达效果。

[0115]

在本实施例中,本技术实施例中,获取虚拟场景中的对话音频片段;确定对话音频片段的情绪类型;将对话音频片段转换为文字文本,得到对话文本内容;计算第一关键词与情绪类型对应关键词表中每个关键词之间的相似度得到多个相似度得分,该第一关键词为所述对话文本内容中的任一关键词;在多个相似度得分中存在相似度得分大于或等于预设相似度阈值的情况下,识别第一关键词的情绪意图;获取情绪意图对应的背景音乐;在对话音频片段中添加背景音乐。由于自动对音视频流中的对话音频片段进行情绪识别,确定情绪类型后根据情绪类型对应的关键词表对对话音频片段进行意图识别,确定该对话音频片段对应的情绪意图,并根据该情绪意图选择相应的背景音乐,再自动将该背景音乐添加至虚拟场景的对话音频片段中。提高了在虚拟场景的对话片段中添加背景音乐的自动化。此外,通过自动化高的背景音乐添加方式减少了对话音频处理的成本。

[0116]

请参阅图4,图4为本技术实施例提供的音乐添加方法的另一流程示意图。该音乐添加方法还可以包括以下步骤。

[0117]

201、获取虚拟场景中的对话音频片段;

[0118]

202、确定所述对话音频片段的情绪类型;

[0119]

203、将所述对话音频片段转换为文字文本,得到对话文本内容;

[0120]

204、在所述对话文本内容中提取第一关键词;

[0121]

205、获取情绪类型对应的关键词表;

[0122]

206、计算第一关键词与所述情绪类型对应关键词表中每个关键词之间的相似度得到多个相似度得分,所述第一关键词为所述对话文本内容中的任一关键词;

[0123]

207、在所述多个相似度得分中存在相似度得分大于或等于预设相似度阈值的情况下,识别所述第一关键词的情绪意图;

[0124]

208、获取所述情绪意图对应的背景音乐;

[0125]

209、在所述对话音频片段中添加所述背景音乐。

[0126]

其中,步骤201至步骤209的具体实现过程可参见上述图2所对应实施例中的描述,这里将不再继续进行赘述。

[0127]

210、获取第一播放音量。

[0128]

该第一播放音量为对话音频片段的播放音量。

[0129]

211、根据所述第一播放音量确定第二播放音量。

[0130]

该第二播放音量为背景音乐的播放音量。

[0131]

212、根据第二播放音量播放背景音乐。

[0132]

在对话音频片段中添加背景音乐时,可以检测对话音频片段的播放音量。根据对话音频片段的播放音量控制添加进来的背景音乐的音量,得到背景音乐的播放音量。

[0133]

可理解地,在对话音频片段中添加背景音乐应该达到背景音乐增强对话音频片段

的表达效果的目的。因此,背景音乐的音量可以控制在预设范围内,是的背景音乐添加至该对话音频片段中能够加强对话音频片段的表达效果。

[0134]

在本实施例中,本技术实施例中,获取虚拟场景中的对话音频片段;确定对话音频片段的情绪类型;将对话音频片段转换为文字文本,得到对话文本内容;计算第一关键词与情绪类型对应关键词表中每个关键词之间的相似度得到多个相似度得分,该第一关键词为所述对话文本内容中的任一关键词;在多个相似度得分中存在相似度得分大于或等于预设相似度阈值的情况下,识别第一关键词的情绪意图;获取情绪意图对应的背景音乐;在对话音频片段中添加背景音乐。由于自动对音视频流中的对话音频片段进行情绪识别,确定情绪类型后根据情绪类型对应的关键词表对对话音频片段进行意图识别,确定该对话音频片段对应的情绪意图,并根据该情绪意图选择相应的背景音乐,再自动将该背景音乐添加至虚拟场景的对话音频片段中。提高了在虚拟场景的对话片段中添加背景音乐的自动化,并通过自动化高的背景音乐添加方式减少了对话音频处理的成本。此外,通过自动控制对话音频片段中添加的背景音乐的播放音量,提升背景音乐的添加效果。

[0135]

请参阅图5,图5是本技术实施例公开的一种音效添加装置500的结构示意图,该音效添加装置500应用于终端,其中该音效添加装置500可以包括:

[0136]

第一获取单元501,用于获取虚拟场景中的对话音频片段;

[0137]

第一确定单元502,用于确定所述对话音频片段的情绪类型;

[0138]

转换单元503,用于将所述对话音频片段转换为文字文本,得到对话文本内容;

[0139]

计算单元504,用于计算第一关键词与所述情绪类型对应关键词表中每个关键词之间的相似度得到多个相似度得分,所述第一关键词为所述对话文本内容中的任一关键词;

[0140]

识别单元505,用于在所述多个相似度得分中存在相似度得分大于或等于预设相似度阈值的情况下,识别所述第一关键词的情绪意图;

[0141]

第二获取单元506,用于获取所述情绪意图对应的背景音乐;

[0142]

添加单元507,用于在所述对话音频片段中添加所述背景音乐。

[0143]

在一些实施例中,所述第一确定单元502具体用于:

[0144]

基于情绪检测模型提取所述对话音频片段的音频属性特征;

[0145]

根据所述音频属性特征,确定所述对话音频片段的情绪类型。

[0146]

在一些实施例中,所述音效添加装置500还包括:

[0147]

提取单元508,用于在所述对话文本内容中提取所述第一关键词;

[0148]

第三获取单元509,用于获取所述情绪类型对应的关键词表。

[0149]

在一些实施例中,所述计算单元504具体用于:

[0150]

计算所述第一关键词的第一词汇向量;

[0151]

计算第二关键词的第二词汇向量,所述第二关键词为所述情绪类型对应关键词表中的任一关键词;

[0152]

基于余弦距离公式计算所述第一词汇向量与所述第二词汇向量之间的相似度得分,得到多个相似度。

[0153]

在一些实施例中,所述识别单元505具体用于:

[0154]

将第一关键词输入意图识别模型,得到所述第一关键词对应的情绪意图,所述关

键词与情绪意图的对应关系根据预设的应用场景设置。

[0155]

在一些实施例中,所述第二获取单元506具体用于:

[0156]

从所述情绪意图对应的音频数据库中选择背景音乐。

[0157]

在一些实施例中,所述添加单元507具体用于:

[0158]

检测所述对话音频片段中存在的静音片段;

[0159]

确定所述静音片段的静音时长;

[0160]

在所述静音时长超过预设阈值的情况下,在所述静音片段添加所述背景音乐。

[0161]

在一些实施例中,所述音效添加装置500,还包括:

[0162]

第四获取单元510,用于获取第一播放音量,所述第一播放音量为所述对话音频片段的播放音量;

[0163]

第二确定单元511,用于根据所述第一播放音量确定第二播放音量,所述第二播放音量为所述背景音乐的播放音量;

[0164]

播放单元512,用于根据所述第二播放音量播放所述背景音乐。

[0165]

所属领域的技术人员可以清楚地了解到,为描述的方便和简洁,上述描述装置和模块的具体工作过程,可以参考前述方法实施例中的对应过程,在此不再赘述。

[0166]

在本技术所公开的几个实施例中,模块相互之间的耦合可以是电性,机械或其它形式的耦合。

[0167]

另外,在本技术各个实施例中的各功能模块可以集成在一个处理模块中,也可以是各个模块单独物理存在,也可以两个或两个以上模块集成在一个模块中。上述集成的模块既可以采用硬件的形式实现,也可以采用软件功能模块的形式实现。

[0168]

本技术实施例还提供一种计算机设备,该计算机设备可以为终端,如图6所示,本技术实施例还公开一种计算机设备600的结构示意图,该计算机设备600包括处理器610、存储器620,存储器620存储有计算机程序指令,计算机程序指令被处理器610调用时,可执行上述的实施例公开的各种方法步骤。本领域技术人员可以理解,图中示出的计算机设备的结构并不构成对计算机设备的限定,可以包括比图示更多或更少的部件,或者组合某些部件,或者不同的部件布置。其中:

[0169]

处理器610可以包括一个或多个处理核。处理器610利用各种接口和线路连接整个电池管理系统内的各种部分,通过运行或执行存储在存储器620内的指令、程序、代码集或指令集,调用存储在存储器620内的数据,执行电池管理系统的各种功能和处理数据,以及执行计算机设备的各种功能和处理数据,从而对计算机设备进行整体监控。可选地,处理器610可以采用数字信号处理(digital signal processing,dsp)、现场可编程门阵列(field-programmable gate array,fpga)、可编程逻辑阵列(programmable logic array,pla)中的至少一种硬件形式来实现。处理器610可集成中央处理器610(central processing unit,cpu)、图像处理器610(graphics processing unit,gpu)和调制解调器等中的一种或几种的组合。其中,cpu主要处理操作系统、用户界面和应用程序等;gpu用于负责显示内容的渲染和绘制;调制解调器用于处理无线通信。可以理解的是,上述调制解调器也可以不集成到处理器610中,单独通过一块通信芯片进行实现。

[0170]

存储器620可以包括随机存储器620(random access memory,ram),也可以包括只读存储器620(read-only memory)。存储器620图可用于存储指令、程序、代码、代码集或指

令集。存储器620可包括存储程序区和存储数据区,其中,存储程序区可存储用于实现操作系统的指令、用于实现至少一个功能的指令(比如触控功能、声音播放功能、图像播放功能等)、用于实现下述各种方法实施例的指令等。存储数据区还可以存储计算机设备在使用中所创建的数据(比如电话本、音视频数据、聊天记录数据)等。相应地,存储器620还可以包括存储器控制器,以公开处理器610对存储器620的访问。

[0171]

尽管未示出,计算机设备600还可以包括显示单元等,在此不再赘述。具体在本实施例中,计算机设备中的处理器610会按照如下的指令,将一个或一个以上的应用程序的进程对应的可执行文件加载到存储器620中,并由处理器610来运行存储在存储器620中的应用程序,从而实现前述实施例公开的各种方法步骤。

[0172]

如图7所示,本技术实施例还公开一种计算机可读存储介质700,该计算机可读存储介质700中存储有计算机程序指令710,计算机程序指令710可被处理器调用以执行上述实施例中所描述的方法。

[0173]

计算机可读存储介质可以是诸如闪存、eeprom(电可擦除可编程只读存储器)、eprom、硬盘或者rom之类的电子存储器。可选地,计算机可读存储介质包括非易失性计算机可读存储介质(non-transitory computer-readable storage medium)。计算机可读存储介质700具有执行上述方法中的任何方法步骤的程序代码的存储空间。这些程序代码可以从一个或者多个计算机程序产品中读出或者写入到这一个或者多个计算机程序产品中。程序代码可以例如以适当形式进行压缩。

[0174]

根据本技术的一个方面,公开了一种计算机程序产品或计算机程序,该计算机程序产品或计算机程序包括计算机指令,该计算机指令存储在计算机可读存储介质中。煎药电器的处理器从计算机可读存储介质读取该计算机指令,处理器执行该计算机指令,使得该煎药电器执行上述实施例公开的各种可选实现方式中公开的方法。

[0175]

在上述实施例中,对各个实施例的描述都各有侧重,某个实施例中没有详述的部分,可以参见上文针对音乐添加方法的详细描述,此处不再赘述。

[0176]

本领域普通技术人员可以理解,上述实施例的各种方法中的全部或部分步骤可以通过指令来完成,或通过指令控制相关的硬件来完成,该指令可以存储于一计算机可读存储介质中,并由处理器进行加载和执行。

[0177]

以上对本技术实施例所提供的一种音乐添加方法、装置、计算机设备及计算机可读存储介质进行了详细介绍,本文中应用了具体个例对本技术的原理及实施方式进行了阐述,以上实施例的说明只是用于帮助理解本技术的方法及其核心思想;同时,对于本领域的技术人员,依据本技术的思想,在具体实施方式及应用范围上均会有改变之处,综上所述,本说明书内容不应理解为对本技术的限制。

当前第1页1

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!