用于信号传递认知状态转换的系统和方法与流程-j9九游会真人

1.本公开总体上涉及用于使用生物信号(例如,眼动追踪数据、或指示注视动态的其他生物信号)来实时预期和信号传递向用户的认知状态(例如视觉搜索、信息编码、重演、存储和/或检索)转换、从用户的认知状态转换和/或在用户的认知状态之间转换的系统和方法。

背景技术:

2.增强现实(augmented reality,ar)系统、虚拟现实(virtual reality,vr)系统和混合现实(mixed reality,mr)系统(统称为扩展现实(extended reality,xr)系统)是当前个人计算系统的正在发展的部分。xr系统(尤其是可穿戴的xr系统(例如,头戴式xr系统))可能即将通过向用户提供持续的“始终在线(always-on)”的协助来开启一个全新的个人计算时代,这些协助可以无缝地结合到用户的日常生活中,而不会造成干扰。与更传统的个人计算设备(例如,笔记本电脑或智能手机)相比,xr设备可能能够以更易访问、更低摩擦的方式向用户显示输出。例如,一些头戴式xr设备可以包括这样的显示器:所述显示器始终在用户的视场角中,xr设备可以利用所述显示器向用户呈现视觉输出。

3.不幸的是,传统的xr设备通常依赖于这样的输入模式(例如,手势或语音):所述输入模式是复杂的、模棱两可的、较低精度的和/或较大噪声的,这些输入模式可能使得由传统的xr设备提供的信息或工具难以访问和导航,并且在身体上和认知上令人疲劳。一些传统的头戴式xr设备可以(例如,通过在真实世界的对象上放置标签或菜单)尝试自动地将显示的输出耦合到用户的物理环境,使得用户可以更容易地使用所显示的输出。虽然更容易访问,但是以这种方式显示的信息可能会使用户分心或厌烦。此外,传统的xr设备通常具有这样的交互环境:所述交互环境是未知的、较不为人知的或未预先指定的,这可能会导致一些xr系统消耗相当大量的计算资源来发现用户环境内的对象,该对象是xr设备可能尝试促进用户与之交互的对象。如果用户没有立即或将来与其环境中的对象进行交互的意图,则发现对象和/或可能的用户交互所消耗的任何资源都可能会被浪费。

技术实现要素:

4.根据第一方面,提供了一种计算机实现的方法,该方法包括:通过一个或多个生物传感器获取由计算系统的用户产生的一个或多个生物信号,该计算系统包括智能助益子系统,该智能助益子系统适于执行一个或多个辅助动作以减少用户的认知负担;使用该一个或多个生物信号来预期向用户的认知状态转换或从用户的认知状态转换;以及向该智能助益子系统提供指示向用户的认知状态转换或从用户的认知状态转换的信号。

5.该获取、使用以及提供可以在该用户没有专心使用计算系统时执行。

6.该一个或多个生物传感器可以包括一个或多个眼动追踪传感器。该一个或多个生物信号可以包括指示用户的注视动态的信号。指示用户的注视动态的信号可以用于预期向用户的认知状态转换或从用户的认知状态转换。

7.指示用户的注视动态的信号可以包括注视速度的测量值。

8.指示用户的注视动态的信号可以包括以下项中的至少一项:环境注意力的测量值;或聚焦注意力的测量值。

9.指示用户的注视动态的信号可以包括扫视动态的测量值。

10.该一个或多个生物传感器可以包括一个或多个手势追踪传感器。该一个或多个生物信号可以包括指示用户的手部动态的信号。指示用户的手部动态的信号可以用于预期向用户的认知状态转换或从用户的认知状态转换。

11.该一个或多个生物传感器可以包括一个或多个神经肌肉传感器。该一个或多个生物信号可以包括从用户的身体获得的神经肌肉信号。从用户的身体获得的神经肌肉信号可以用于预期向用户的认知状态转换或从用户的认知状态转换。

12.该用户的认知状态可以包括以下项中的一项或多项:将信息编码到用户的工作记忆的状态;视觉搜索的状态;将信息存储到用户的长期记忆的状态;以及从用户的长期记忆中检索信息的状态。

13.该计算机实现的方法还可以包括:通过该智能助益子系统接收指示了向用户的认知状态转换或从用户的认知状态转换的信号;以及通过该智能助益子系统执行该一个或多个辅助动作以减少用户的认知负担。

14.使用该一个或多个生物信号来预期向用户的认知状态转换或从用户的认知状态转换可以包括:使用该一个或多个生物信号来预期用户将信息编码到用户的工作记忆中的意图。执行该一个或多个辅助动作以减少用户的认知负担可以包括:向用户呈现以下项中的至少一项:虚拟记事本、虚拟列表、或虚拟画板;接收来自用户的指示该信息的输入;以及通过该智能助益子系统存储该信息的表示以供以后检索并呈现给用户。

15.该计算系统可以包括物理存储器。执行该一个或多个辅助动作以减少用户的认知负担可以包括:通过该智能助益子系统识别倾向于被编码到用户的工作记忆中的、用户的环境的至少一个属性;以及将该属性存储到该物理存储器中,以供以后检索并呈现给用户。该智能助益子系统在接收到指示向用户的认知状态转换或从用户的认知状态转换的信号之前,可以不对用户的环境的至少一个属性进行识别。

16.根据第二方面,提供了一种系统,该系统包括:智能助益子系统,该智能助益子系统适于执行一个或多个辅助动作以减少用户的认知负担;一个或多个生物传感器,该一个或多个生物传感器适于检测由用户产生的生物信号;至少一个物理处理器;以及物理存储器,该物理存储器包括计算机可执行指令,该计算机可执行指令在由该物理处理器执行时,使该物理处理器执行第一方面的方法。该系统可以是扩展现实系统。

17.根据第三方面,提供了一种计算机可读介质,该计算机可读介质包括指令,该指令在由计算机执行时,使该计算机执行第一方面的方法。该介质可以是非暂态的。

18.根据第四方面,提供了一种计算机程序产品,该计算机程序产品包括指令,在该程序由计算机执行时,该指令使该计算机执行第一方面的方法。

19.在一些实施例中,所公开的系统可以预期用户何时想要将信息编码到用户的工作记忆中,并且可以(例如经由自适应界面和/或预测界面)智能地执行一个或多个辅助动作或干预,以减少记忆信息和/或回忆信息所涉及的身体负担和认知负担。通过预期用户的认知状态转换的时间,本文所公开的系统和方法可以响应性地驱动超低摩擦预测界面以促进

用户的认知任务和目标。在一些实施例中,所公开的系统和方法可以生成指示用户的认知状态转换的时间的信号,该信号可以允许智能助益系统恰好在正确的时间提供自适应干预。

20.根据本文所描述的一般原理,来自本文所描述的多个实施例中的任何实施例的多个特征可以彼此组合使用。在结合附图和权利要求书阅读以下具体实施方式时,将更充分地理解这些和其他的实施例、这些和其他特征、以及这些和其他优点。

附图说明

21.附图示出了许多示例,且是说明书的一部分。这些附图与下面的描述一起展示并解释了本公开的各种原理。

22.图1是如下示例性系统的框图:该示例性系统用于信号传递向用户的认知状态转换、从用户的认知状态转换、和/或在用户的认知状态之间转换,和/或对向用户的认知状态转换、从用户的认知状态转换出、和/或在用户的认知状态之间转换作出反应。

23.图2是示例性认知状态和对应的转换的示意图。

24.图3是与示例性智能助益子系统相关联的示例性数据流的示意图。

25.图4是信号传递认知状态转换、和/或对认知状态转换作出反应的示例性可穿戴设备的框图。

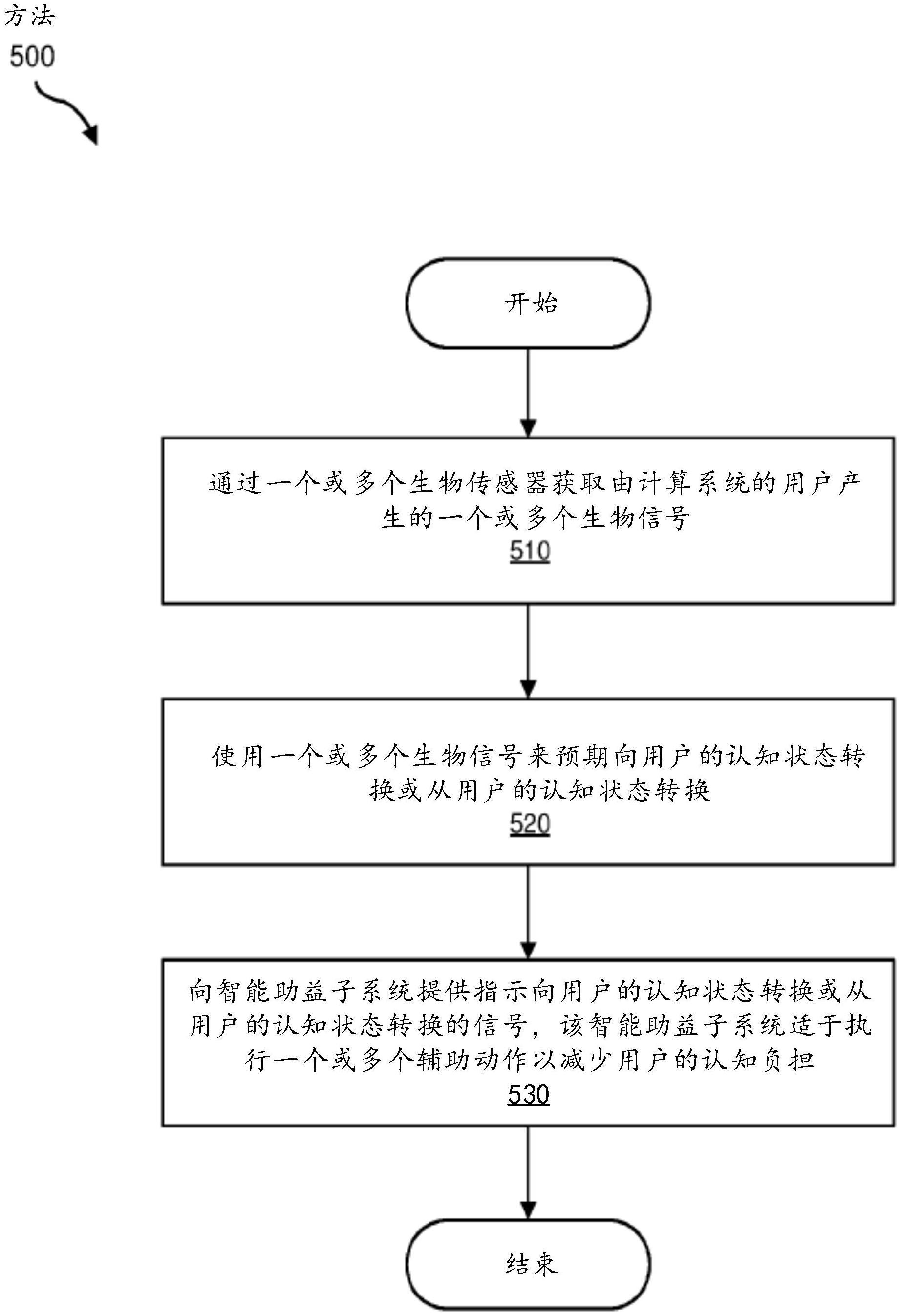

26.图5是用于信号传递认知状态转换的示例性方法的流程图。

27.图6是用于使用生物传感器数据来生成认知状态转换的信号的示例性数据流的示意图。

28.图7是用于根据眼动追踪数据生成注视事件和其他注视特征的示例性预处理数据流的示意图。

29.图8是用于响应于认知状态转换而智能地促进用户的认知任务和/或目标的示例性方法的流程图。

30.图9是用于执行辅助动作以减少与用户的认知任务和/或目标相关联的认知负担的示例性子步骤的流程图。

31.图10是用于执行辅助动作以减少与用户的认知任务和/或目标相关联的认知负担的附加示例性子步骤的流程图。

32.图11是可以与本公开的实施例结合使用的示例性增强现实眼镜的图示。

33.图12是可以与本公开的实施例结合使用的示例性虚拟现实头戴式设备(headset)的图示。

34.图13是可以与本公开的实施例结合使用的示例性触觉设备的图示。

35.图14是示例性虚拟现实的图示。

36.图15是示例性增强现实环境的图示。

37.图16是这样的示例性系统的图示:所述系统包括能够追踪用户单眼或双眼的眼动追踪子系统。

38.图17是图16所示的眼动追踪子系统的各个方面的更详细的图示。

39.图18a和图18b是被配置为佩戴在用户的前臂或手腕上的示例性人机接口的图示。

40.图19a和图19b是可穿戴系统的内部部件的示例性示意图的图示。

41.图20是示例性生物信号传感系统的多个部件的示意图。

42.在所有附图中,相同的附图标记和描述指示相似但不一定相同的元件。虽然本文所描述的示例易于进行各种修改和形式替代,但是仍通过示例的方式在附图中显示了具体设置,并且即将在本文中对这些具体实施例进行详细描述。然而,本文所描述的示例性实施例并不旨在被限制为所公开的特定形式。而是,本公开涵盖了落入所附权利要求书的范围内的所有修改、等同物和替代物。

具体实施方式

43.下面将参考图1至图4提供用于预期、信号传递和/或适应认知状态转换的示例性系统和子系统的详细描述。与图5至图10相对应的论述将提供对应方法和数据流的详细描述。最后,下面将参考图11至图20提供可实现本公开各实施例的各种扩展现实系统和部件的详细描述。

44.图1是用于信号传递示例系统100的用户的各种认知状态之间的转换的示例系统100的框图。如该图所示出的,系统100可以包括用于执行一个或多个任务的一个或多个模块102。如下面将更详细解释的,模块102可以包括获取模块104,该获取模块获取由系统100的用户产生的生物信号(例如,指示注视动态的眼动追踪信号)。示例系统100还可以包括预测模块106,该预测模块使用由获取模块104获取的生物信号,来预期向用户的认知状态转换(例如转变或切换)、从用户的认知状态转换(例如转变或切换)和/或在用户的认知状态之间转换(例如转变或切换)。例如,预测模块106可以使用由获取模块104获取的生物信号来预期向图2所示的示例认知状态中的任何状态转换、从图2所示的示例认知状态中的任何状态转换、和/或在图2所示的示例认知状态中的任何状态之间转换。示例系统100还可以包括信号传递模块108,该信号传递模块向一个或多个智能助益子系统提供指示在用户的认知状态之间转换的信号。

45.如下面将更详细解释的,所公开的系统可以预期向各种认知状态转换、从各种认知状态转换和/或在各种认知状态之间转换。如本文所使用的,术语“认知状态”可以指或包括用户通过思考、体验和/或感知来获取信息(knowledge)和/或意识所涉及的一个或多个认知任务、一个或多个功能和/或一个或多个过程。附加地或替代地,术语“认知状态”可以指或包括与知觉、专注、构思、记忆、推理、判断、理解、问题解决和/或决策制定有关的认知的一个或多个任务、一个或多个功能和/或一个或多个过程。在一些示例中,术语“认知状态”可以指或包括内部心理状态,该内部心理状态可能不能在外部观察到。

46.图2示出了示例性认知状态200及其转换。在该示例中,认知状态200可以包括搜索状态202,其中,用户将来自用户的感官的感觉输入204捕获到用户的感觉记忆206中。在一些示例中,搜索状态202可以表示任何认知状态或任务,其中,用户从呈现给用户和/或先前由用户记忆的干扰刺激物中搜索(例如,视觉搜索)目标刺激物(例如,用户环境中的实体,诸如物、人或条件,该物、人或条件可以充当刺激物和/或可以引起用户的反应)。在一些示例中,感觉输入204可以表示或包括由用户的感觉器官产生的任何感觉信息,并且感觉记忆206可以表示或包括用户的神经系统的一部分,神经系统的该部分在被编码到长期记忆中之前短暂地保持感觉信息。

47.如图2所示,认知状态200可以包括编码状态208,在该编码状态中,感觉输入204被

转换成能够被处理的形式并存储到用户的工作记忆210中。在一些示例中,工作记忆210可以表示和/或包括用户的任何短期、临时或初级记忆。认知状态200还可以包括重演状态212,在该重演状态中(例如,为了将存储到工作记忆的信息在工作记忆210中保持地更久)用户在思想上对存储到工作记忆210的信息进行重复。认知状态还可以包括转移状态214,在该转移状态中,来自工作记忆210的信息被转移到用户的长期记忆216并保存在用户的长期记忆216中。在一些示例中,长期记忆216可以表示或包括用户的任何长期、永久或次级记忆。认知状态200可以附加地包括检索状态218,在该检索状态中,存储在长期记忆216中的信息位于长期记忆216内和/或被恢复到工作记忆210。

48.返回到图1,例如,示例系统100可以包括一个或多个智能助益子系统(例如,一个或多个智能助益子系统101),该智能助益子系统可以通过执行一个或多个辅助动作或一个或多个辅助干预来对用户的认知状态转换进行响应或对用户的认知状态转换作出反应,该一个或多个辅助动作或一个或多个辅助干预减少与所涉及的认知状态和/或任何其他相关联的认知状态相关联的精神负担、努力或劳动。在一个示例中,一个或多个智能助益子系统101可以通过执行一个或多个辅助动作来对向搜索状态202的转换进行响应,该一个或多个辅助动作减少了用户的与搜索状态202相关的精神负担、努力或劳动。例如,一个或多个智能助益子系统101可以通过向用户呈现经常搜索项目和/或其最后记录位置的列表以方便用户对该项目的搜索,来减少用户的与搜索状态202相关联的精神负担、努力或劳动。在另一示例中,一个或多个智能助益子系统101可以通过执行一个或多个辅助动作来对向编码状态208、重演状态212和/或转移状态214的转换进行响应,该一个或多个辅助动作减少了与编码状态208、重演状态212和/或转移状态214相关联的精神负担、努力或劳动。例如,一个或多个智能助益子系统101可以通过向用户呈现辅助工具来减少与编码状态208、重演状态212和/或转移状态214相关联的精神负担、努力或劳动,该辅助工具使用户能够将用户在编码状态208、重演状态212和/或转移状态214期间在编码、重演和/或转移过程中的任何信息记录到存储器120以供以后检索。如下文将更详细描述的,一个或多个智能助益子系统101可以以各种附加方式来对认知状态转换进行响应。

49.图3示出了一个或多个智能助益子系统101的示例性数据流300,该智能助益子系统用于响应于认知状态转换,使用自适应界面和干预来智能地促进用户的认知任务和目标。在该示例中,信号传递模块108可以向智能助益子系统101提供状态转换信号302,该状态转换信号指示认知状态转换的开始或发生。在一些示例中,智能助益子系统101可以通过使用一个或多个用户界面107向用户呈现辅助工具304,来对状态转换信号302作出反应,该辅助工具304(例如,通过促进对来自用户的信息308的收集)智能地促进用户的当前认知状态或未来认知状态。在一些示例中,信息308可以表示、包括如下信息、和/或与如下信息相关:所述信息已经被或正在被编码到用户的工作记忆中和/或转移到用户的长期记忆中。附加地或替代地,智能助益子系统101可以通过在用户知情或不知情的情况下执行一个或多个辅助干预306,来对状态转换信号302作出反应,该一个或多个辅助干预将信息308存储到存储器120。例如,智能助益子系统101可以通过收集关于用户和/或用户环境的信息来对状态转换信号302作出反应,用户可以在以后需要时访问这些信息。

50.在一些示例中,辅助工具304可以表示或包括减少与用户的当前认知状态或未来认知状态相关联的精神负担、努力或劳动的任何工具。辅助工具304可以包括或表示记事

本、清单、购物清单、杂货清单、任务清单、提醒清单、日志、日记、目录、库存、日历、联系人管理器、钱包、画板、照片工具、视频工具、音频工具、地图、电子商务工具、便于对来自用户的信息进行收集的用户输入工具、便于对存储在存储器120中的信息进行搜索和/或检索的信息管理工具、他们中的一者或多者的变型或组合,或可以辅助用户的认知任务和/或目标的任何其他类型或形式的工具。在一些示例中,辅助干预306可以包括或表示便于辅助工具304的任何动作或过程。

51.再次返回图1,示例系统100可以包括一个或多个传感器(例如,一个或多个生物传感器103、和/或一个或多个环境传感器105),该一个或多个传感器用于获取关于示例系统100的用户和/或用户的环境的信息。在一些示例中,一个或多个生物传感器103可以表示或包括一个或多个生理传感器,该一个或多个生理传感器能够生成指示用户的一个或多个生理特性的实时生物信号、和/或用于对由用户产生的生物电位信号进行实时测量。生理传感器可以表示或包括如下的任何传感器:所述传感器检测或测量用户的生理特性或方面(例如,注视、心率、呼吸、出汗、皮肤温度、身体姿势等)。在一些示例中,一个或多个生物传感器103可以收集、接收和/或识别生物传感器数据,该生物传感器数据直接或间接地指示如下生理信息:所述生理信息可以与用户的认知状态转换相关联、和/或可以帮助识别用户的认知状态转换。在一些示例中,一个或多个生物传感器103可以表示或包括一个或多个面向人的传感器,该一个或多个面向人的传感器能够测量用户的生理特性。一个或多个生物传感器103的示例包括但不限于:眼动追踪传感器、手势追踪传感器、身体追踪传感器、心率传感器、心脏传感器、神经肌肉传感器、眼电图(electrooculography,eog)传感器、肌电图(electromyography,emg)传感器、脑电图(electroencephalography,eeg)传感器、心电图(electrocardiography,ecg)传感器、传声器、可见光摄像头、红外摄像头、环境光传感器(ambient light sensor,als)、惯性测量单元(inertial measurement unit,imu)、热流传感器、被配置为测量皮肤温度的温度传感器、湿度传感器、生化传感器、触摸传感器、接近传感器、生物识别传感器、饱和氧传感器(saturated-oxygen sensor)、生物电位传感器、生物阻抗传感器、计步器传感器、光学传感器、汗液传感器、以上中的一者或多者的变型或组合、或任何其他类型或形式的生物信号传感设备或系统。

52.在一些示例中,一个或多个环境传感器105可以表示或包括如下的一个或多个传感设备:所述一个或多个传感设备能够生成指示用户环境的一个或多个特性的实时信号。在一些示例中,一个或多个环境传感器105可以收集、接收和/或识别如下数据:所述数据直接或间接地指示用户环境内的用户可能希望与之交互和/或记忆的实体(例如,物、人或条件)。一个或多个环境传感器105的示例包括但不限于:摄像头、传声器、同时定位与地图构建(simultaneous localization and mapping,slam)传感器、射频识别(radio-frequency identification,rfid)传感器、以上中的一者或多者的变型或组合、或任何其他类型或形式的环境传感设备或系统、或对象传感设备或系统。

53.进一步如图1所示,示例系统100还可以包括一个或多个转换预测模型(例如,一个或多个转换预测模型140),该一个或多个转换预测模型被训练为和/或以其他方式被配置为预测认知状态转换、和/或以其他方式使用生物信号信息对认知状态转换进行建模。在至少一个示例中,一个或多个转换预测模型140可以包括或表示基于注视的预测模型,该基于注视的预测模型将指示注视动态和/或眼球运动的信息作为输入,并输出一个或多个认知

状态转换的预测(例如,概率或二进制(binary)指示符)。在一些示例中,所公开的系统可以对转换预测模型140进行训练以进行用户的认知状态转换的实时预测、从注视数据中解码认知状态间的转换时间、和/或预测认知状态的开始时间。在一些示例中,所公开的系统可以对转换预测模型140进行训练,以仅使用在转换时刻之前的注视动态来预测认知状态间的转换的开始时间。在至少一个示例中,所公开的系统可以对转换预测模型140进行训练,以仅使用转换事件之前的眼动追踪数据来预测认知状态转换的开始时间。

54.一个或多个转换预测模型140可以表示或包括如下的任何机器学习模型、算法、启发式方法、数据、或它们的组合:所述机器学习模型、算法、启发式方法、数据、或它们的组合可以基于和/或使用从一个或多个生物传感器(例如,生物传感器103)获取的生物信号,来预期、识别、检测、估计、预测、标记、推断用户的认知状态转换的开始时间,和/或对用户的认知状态转换的开始时间作出反应。一个或多个转换预测模型140的示例包括但不限于:决策树(例如,提升决策树)、神经网络(例如,深度卷积神经网络)、深度学习模型、支持向量机、线性分类器、非线性分类器、感知器、朴素贝叶斯分类器、任何其他机器学习或分类技术或算法、或它们的任意组合。

55.本文描述的系统可以对转换预测模型(例如,转换预测模型140)进行训练,从而以任何合适的方式预测认知状态转换的时间。在一个示例中,系统可以对转换预测模型进行训练,以使用一真实时间序列的生理数据来预测用户何时开始和/或将要进行两种认知状态之间的转换,该生理数据包括在两种认知状态之间的转换之前和/或直到两种认知状态之间的转换时记录的生理数据。在一些示例中,时间序列可以包括如下样本:所述样本处于用户的两种认知状态之间的转换之前大约10ms、50ms、100ms、200ms、300ms、400ms、500ms、600ms、700ms、800ms、900ms、1000ms、1100ms、1200ms、1300ms、1400ms、1500ms、1600ms、1700ms、1800ms、1900ms或2000ms。附加地或替代地,时间序列包括如下样本:所述样本处于两种认知状态之间的转换之前大约2100ms、2200ms、2300ms、2400ms、2500ms、2600ms、2700ms、2800ms、2900ms、3000ms、3100ms、3200ms、3300ms、3400ms、3500ms、3600ms、3700ms、3800ms、3900ms、4000ms、4100ms、4200ms、4300ms、4400ms、4500ms、4600ms、4700ms、4800ms、4900ms、5000ms、5100ms、5200ms、5300ms、5400ms、5500ms、5600ms、5700ms、5800ms、5900ms、6000ms、6100ms、6200ms、6300ms、6400ms、6500ms、6600ms、6700ms、6800ms、6900ms、7000ms、7100ms、7200ms、7300ms、7400ms、7500ms、7600ms、7700ms、7800ms、7900ms、8000ms、8100ms、8200ms、8300ms、8400ms、8500ms、8600ms、8700ms、8800ms、8900ms、9000ms、9100ms、9200ms、9300ms、9400ms、9500ms、9600ms、9700ms、9800ms、9900ms、10000ms、10100ms、10200ms、10300ms、10400ms、10500ms、10600ms、10700ms、10800ms、或10900ms。在一些示例中,转换预测模型可以将类似时间序列的生理数据作为输入。

56.在一些示例中,所公开的系统可以使用一个或多个转换预测模型(例如,针对单个用户而训练的转换预测模型、或针对一组用户而训练的转换预测模型)。在至少一个示例中,所公开的系统可以对模型进行训练,以针对毫秒量级或秒量级的认知状态转换进行预测。

57.进一步如图1所示,示例系统100还可以包括一个或多个存储设备,例如存储器120。存储器120可以包括或表示能够存储数据和/或计算机可读指令的任何类型或形式的易失性或非易失性存储设备或存储介质。在一个示例中,存储器120可以存储、加载和/或维

护多个模块102中的一个或多个模块。存储器120的示例包括但不限于:随机存取存储器(random access memory,ram)、只读存储器(read only memory,rom)、闪存、硬盘驱动器(hard disk drive,hdd)、固态驱动器(solid-state drive,ssd)、光盘驱动器、高速缓冲存储器、以上中的一者或多者的变型或组合、或任何其他合适的存储器。

58.进一步如图1所示,示例系统100还可以包括一个或多个物理处理器,例如物理处理器130。物理处理器130可以包括或表示能够解释和/或执行计算机可读指令的任何类型或形式的、硬件实现的处理单元。在一个示例中,物理处理器130可以访问和/或修改存储在存储器120中的多个模块102中的一个或多个模块。附加地或替代地,物理处理器130可以执行多个模块102中的一个或多个模块,以便于预测或信号传递认知状态转换。物理处理器130的示例包括但不限于:微处理器、微控制器、中央处理单元(central processing unit,cpu)、实现软核处理器的现场可编程门阵列(field-programmable gate array,fpga)、专用集成电路(application-specific integrated circuit,asic)、以上中的一者或多者中的部分、以上中的一者或多者的变型或组合、或任何其他合适的物理处理器。

59.图1中的系统100可以以各种方式实现。例如,系统100的全部或一部分可以表示图4中的示例系统400中的部分。如图4所示,系统400可以包括可穿戴设备402(例如,可穿戴xr设备),该可穿戴设备具有:(1)一个或多个面向用户的传感器(例如,一个或多个生物传感器103),该一个或多个面向用户的传感器能够获取由用户404产生的生物信号数据;(2)一个或多个面向环境的传感器(例如,一个或多个环境传感器105),该一个或多个面向环境的传感器能够获取关于用户404的真实世界环境406的环境数据;和/或(3)显示器408,该显示器能够向用户404显示辅助工具。

60.如图4所示,可以使用来自图1中的多个模块102中的一个或多个模块(例如,获取模块104、预测模块106和/或信号传递模块108)对可穿戴设备402进行编程,该多个模块中的一个或多个模块在被可穿戴设备402执行时,可以使可穿戴设备402能够:(1)通过一个或多个生物传感器103中的一个或多个生物传感器获取由用户404产生的一个或多个生物信号;(2)使用该一个或多个生物信号来预期向用户404的认知状态转换、从用户404的认知状态转换和/或在用户404的认知状态之间转换;以及(3)向可穿戴设备402的智能助益子系统提供状态转换信号,该状态转换信号指示向用户404的认知状态转换、从用户404的认知状态转换、和/或在用户404的认知状态之间转换。

61.图5是用于信号传递认知状态转换的示例性计算机实现的方法500的流程图。图5中所示的多个步骤可以由任何合适的计算机可执行代码和/或计算系统来执行,该计算系统包括图1至图4、以及图11至图20所示的一个或多个系统。在一个示例中,图5中所示的多个步骤中的每个步骤可以表示这样的算法:该算法的结构包括多个子步骤和/或由多个子步骤表示,下面将更详细地提供该算法的示例。

62.如图5所示,在步骤510处,本文所描述的系统中的一个或多个系统可以通过一个或多个生物传感器获取由计算系统的用户产生的一个或多个生物信号。例如,获取模块104(作为图4中的可穿戴设备402的一部分)可以使用生物传感器103中的一个或多个生物传感器,来获取由用户404产生的一个或多个原始生物信号和/或衍生生物信号。

63.本文所描述的系统可以以各种方式执行步骤510。图6示出了用于获取生物信号数据、并使用该生物信号数据来生成转换信号的示例性数据流600。如该图所示,在一些示例

中,所公开的系统可以接收来自一个或多个生物传感器103的一个或多个原始生物信号602,并且可以使用一个或多个原始生物信号602作为转换预测模型140的输入。附加地或替代地,所公开的系统可以通过对一个或多个原始生物信号602执行一个或多个预处理操作604(例如,事件检测操作或特征提取操作)来生成一个或多个衍生生物信号606,并且随后可以使用一个或多个衍生生物信号606作为转换预测模型140的输入。

64.图7示出了示例性实时预处理流水线700,所公开的系统可以使用该示例性实时预处理流水线将原始的实时眼动追踪数据转换成本文所公开的多个特征中的一个或多个特征,用户的认知状态转换可以从该多个特征中的一个或多个特征中进行预期。在该示例中,所公开的系统可以从眼动追踪系统获取一串实时的3d注视向量(gaze vector)702。在一些示例中,3d注视向量702可以位于眼在头上的参考系中,并且所公开的系统可以使用合适的参考系变换704(例如,使用指示用户头部方位的信息)将3d注视向量702变换到眼在环境的参考系,这可以产生经变换的3d注视向量706。接下来,所公开的系统可以使用合适的角位移计算708来计算来自注视向量706中的连续样本之间的角位移710。例如,所公开的系统可以使用方程式(1)来计算来自注视向量706中的连续样本之间的角位移710:

65.θ=2

×

atan2(‖u-v‖,‖u v‖)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(1)

66.其中,将注视向量706的连续样本表示为归一化向量u和v,并且将对应的角位移表示为θ。

67.然后,所公开的系统可以使用合适的注视速度计算712来根据角位移710计算注视速度714。例如,所公开的系统可以将来自角位移710(例如,如上所计算的θ)的每个样本除以来自注视向量706的相关联的连续样本之间的时间变化。

68.在一些示例中,所公开的系统可以对注视速度712执行一个或多个过滤操作716(例如,以在下游的事件检测和特征提取之前去除噪声和/或不需要的部分)。在至少一个示例中,所公开的系统可以去除注视速度超过约800度/秒的所有样本,这些样本可能指示了对于普通用户不可能的快速眼动。在另一示例中,所公开的系统可以去除注视速度超过约1000度/秒的所有样本,这些样本可以指示对于某些组用户(例如,较年轻的用户)不可能的快速眼动。然后,所公开的系统可以通过插值法来替换去除的值。附加地或替代地,所公开的系统可以将中值滤波器(例如,具有七个样本宽度的中值滤波器)应用于注视速度714,以使信号平滑和/或消除噪声。

69.在一些示例中,所公开的系统可以通过执行一个或多个事件检测操作718来根据注视速度714生成注视事件722。在一些示例中,所公开的系统可以使用任何合适的检测模型、算法或启发式方法来根据注视速度714检测注视(fixation)事件(例如,在单个位置维持视觉注视的时间)和/或扫视事件(例如,注视点之间的快速眼动的时间)。例如,所公开的系统可以使用合适的扫视检测算法(例如,速度阈值识别(velocity-threshold identification,i-vt)、分散阈值识别(dispersion-threshold identification,i-dt)或隐马尔可夫模型识别(hidden markov model identification,i-hmm))来执行扫视检测。在至少一个示例中,所公开的系统可以通过以下方式来执行i-vt扫视检测:识别超过约70度/秒的来自注视速度714的连续样本。在一些示例中,对于扫视事件,所公开的系统可能需要如下的最小持续时间和最大持续时间:该最小持续时间处于约5毫秒至约30毫秒的范围内(例如,17毫秒),该最大持续时间处于约100毫秒至约300毫秒的范围内(例如,200毫秒)。

在一些示例中,所公开的系统可以通过以下方式来执行i-dt注视检测:计算在预定时间窗口上的分散(例如,距注视样本质心的最大角位移)并将分散不超过约1度的时间窗口标记为注视事件。在一些示例中,对于注视事件,所公开的系统可能需要如下的最小持续时间和最大持续时间:该最小持续时间处于约50毫秒至约200毫秒的范围内(例如,100毫秒),该最大持续时间处于约0.5秒到约3秒的范围内(例如,2秒)。

70.在一些示例中,所公开的系统可以通过以下方式来生成注视特征724:对注视向量702、注视向量706、角位移710、注视速度714和/或任何其他合适的眼动追踪数据执行一个或多个事件提取操作720。所公开的系统可以提取各种基于注视的特征,以用于通过计算系统预测认知状态转换。基于注视的特征的示例包括但不限于:注视速度(例如,注视移动的速度的测量值)、环境注意力、聚焦注意力、扫视动态、表征视觉注意力的注视特征、离散度(例如,对注视点在一段时间内如何分散的度量)、事件检测标签、从注视事件722获得的低水平眼动特征、k系数(例如,用于区分聚焦行为和环境行为的系数)、以上中的一者或多者的变型或组合、或任何其他类型或形式的眼动追踪数据。

71.本文所描述的系统可以使用各种注视数据和注视动态来预测认知状态转换何时发生。例如,所公开的系统可以使用以下项的组合来预测认知状态转换的时间:注视速度、来自注视事件和扫视事件的低水平特征、和/或识别扫描路径的形状中的模式的中水平特征。在一些示例中,本文所描述的系统可以基于以下项中的一者或多者的模式和/或要素来预测用户的认知状态转换:注视事件(例如,用户是否专注在某物上)、注视速度、注视平均速度、x方向上的扫视加速度偏斜、y方向上的扫视标准偏差、扫视速度峰度、扫视速度偏斜、y方向上的扫视速度偏斜、扫视持续时间、环境/焦点k系数、扫视速度标准偏差、与先前扫视的扫视距离、离散度、注视持续时间、y方向上的注视峰度、x方向上的扫视速度峰度、x方向上的扫视速度偏斜、扫视幅度、x方向上的扫视标准偏差、x方向上的注视峰度、y方向上的扫视加速度峰度、扫视加速度偏斜、y方向上的注视偏斜、x方向上的扫视加速度峰度、扫视事件(例如,用户是否正在进行扫视)、扫视离散度、x方向上的注视标准偏差、x方向上的注视偏斜、扫视速度均值、y方向上的注视标准偏差、y方向上的扫视速度峰度、与先前注视的注视角度、与先前扫视的扫视角度、x方向上的扫视速度中值、注视路径长度、y方向上的扫视加速度偏斜、注视离散度、扫视加速度峰度、扫视路径长度、y方向上的扫视加速度中值、x方向上的扫视速度均值、y方向上的扫视加速度中值、x方向上的扫视速度均值、x方向上的扫视加速度标准偏差、y方向上的扫视速度均值、扫视加速度均值、x方向上的扫视加速度均值、x方向上的扫视加速度中值、扫视加速度标准偏差、y方向上的扫视加速度标准偏差、y方向上的扫视速度标准偏差、x方向上的扫视加速度最大值、扫视速度中值、x方向上的扫视速度最大值、扫视加速度最大值、扫视加速度中值、y方向上的扫视速度中值、y方向上的扫视加速度均值、扫视比率、x方向上的扫视速度标准偏差。附加地或替代地,本文所描述的系统可以基于以下项来预测用户的认知状态转换:注视速度、环境/聚焦注意力的任何合适测量值、扫视眼动的统计特征、眨眼模式、扫描路径模式、和/或瞳孔特征的变化。

72.返回图5,在步骤520处,本文所描述的系统中的一个或多个系统可以使用在步骤510处获取的一个或多个生物信号,来预期向用户的认知状态转换或从用户的认知状态转换。例如,预测模块106(作为可穿戴设备402的一部分)可以使用生物信号602和/或生物信号606中的一个或多个生物信号,来预期向用户404的认知状态转换或从用户404的认知状

态转换。本文所描述的系统可以以各种方式执行步骤520。在一个示例中,所公开的系统可以使用经适当训练的预测模型(例如,转换预测模型140)来预测认知状态转换的开始。

73.在步骤530处,本文所描述的系统中的一个或多个系统可以向智能助益子系统提供指示在步骤520处预期的认知状态转换的信号。例如,信号传递模块108(作为图4中的可穿戴设备402的一部分)可以向一个或多个智能助益子系统101提供指示用户404的认知状态转换的信号。

74.本文所描述的系统可以以各种方式执行步骤530。在一些示例中,所公开的系统可以使用发布/订阅消息来交换认知状态转换的信号。例如,信号传递模块108可以(例如,使用合适的应用程序编程接口)发布多种信号类型,每种信号类型表明了特定类型的认知状态转换,一个或多个智能助益子系统101(例如,第三方应用)可以订阅该特定类型的认知状态转换和对该特定类型的认知状态转换作出反应。在至少一个示例中,所公开的系统可以在状态转换信号中包括关于认知状态转换的各种信息。例如,所公开的系统可以指示认知状态转换的类型、在转换中涉及的认知状态、认知状态转换的时间、认知状态转换的概率或可能性、正在发生认知状态转换的上下文(例如,环境上下文)、和/或可能有助于智能助益子系统对用户的认知状态转换作出反应的任何其他信息。

75.所公开的智能助益子系统可以以各种方式对状态转换信号进行响应、和/或对状态转换信号作出反应。图8是用于对认知状态转换进行响应或对认知状态转换作出反应的示例性计算机实现的方法800的流程图。图8中所示的多个步骤可以由任何合适的计算机可执行代码和/或计算系统来执行,该计算系统包括图1至图4、以及图11至图20所示的一个或多个系统。在一个示例中,图8中所示的多个步骤中的每个步骤可以表示这样的算法:该算法的结构包括多个子步骤和/或由多个子步骤表示。

76.如图8所示,在步骤810处,本文所描述的系统中的一个或多个系统可以接收指示向用户的认知状态转换或从用户的认知状态转换的信号。例如,智能助益子系统101(作为图4中可穿戴设备402的一部分)可以接收指示向用户404的认知状态转换或从用户404的认知状态转换的信号。在步骤820处,响应于在步骤810处接收到的信号,本文所描述的多个系统中的一个或多个系统可以执行一个或多个辅助动作以减少用户的认知负担。例如,智能助益子系统101(作为图4中可穿戴设备402的一部分)可以向用户404显示辅助工具304和/或执行一个或替代的或附加的辅助动作,以减少用户404的当前认知负担和/或未来认知负担。

77.本文所描述的系统可以以各种方式执行步骤820。图9是用于响应于指示用户将信息编码到工作记忆的意图的信号来执行辅助动作的示例性子步骤900的流程图。在子步骤910处,本文所描述的多个系统中的一个或多个系统可以识别合适的辅助工具(例如上述那些辅助工具)并向用户呈现该辅助工具,以便于用户将经编码的信息提供给系统以用于在机器存储器(例如,存储器120)中重复存储。在一些示例中,所公开的系统可以在无需用户明确请求辅助工具的情况下,自动识别并呈现适合于用户当前认知状态、任务或目标的辅助工具。在子步骤920处,本文所描述的多个系统中的一个或多个系统可以使用辅助工具来接收来自用户的输入,该输入指示经编码的信息。在至少一个示例中,所公开的系统可以通过向用户呈现可能性列表来辅助用户提供信息。然后,在子步骤930处,所公开的多个系统中的一个或多个系统可以将信息的表示存储到机器存储器,以供以后(例如,响应于指示向

检索状态转换的信号)由用户检索和/或呈现给用户。

78.图10是用于响应于指示用户将信息编码到工作记忆的意图的信号来执行辅助动作的附加示例性子步骤1000的流程图。在子步骤1010处,本文所描述的多个系统中的一个或多个系统可以识别倾向于被编码到用户的工作记忆中的、用户的环境的至少一个属性。例如,所公开的系统可以识别用户环境的位置的属性、环境中的实体(例如,对象、人、日期、地址、词汇或图像)的属性、环境中以前从未遇到过的新实体的属性、或先前在环境中的缺失实体的属性。在一些示例中,所公开的系统可以(例如,通过辅助工具)在用户的帮助下和/或在没有用户的帮助或知识的情况下,对用户环境的属性进行识别。在子步骤1020处,本文所描述的多个系统中的一个或多个系统可以将该属性存储到物理存储器以供以后(例如,响应于指示向检索状态转换的信号)呈现给用户。

79.在一些示例中,所公开的系统可以收集和/或记录关于认知状态转换或先前认知状态转换的上下文的信息,以便确定什么辅助工具和/或干预可以最好地帮助用户。在一些示例中,所公开的系统可以基于以下项来确定合适的辅助工具或干预:(1)关于认知状态转换的环境的信息(例如,环境和/或物品先前和/或当前在环境内的位置)、(2)关于用户在环境中的先前和/或当前移动的信息、(3)关于认知状态转换的时间的信息、(4)关于在认知转换之前、期间或之后的用户的聚焦注意力的信息、和/或(5)关于用户先前使用辅助工具的信息。

80.在一个非限制性示例中,所公开的系统可以在(例如,基于在用户厨房发生的向用户的编码状态的转换)确定用户可能正在将杂货物品编码到工作记忆中之后,向用户呈现杂货清单。在另一个非限制性示例中,所公开的系统可以在(例如,基于对用户视场角中的联系人信息(例如,电话号码)的检测)确定用户可能正在将联系人信息编码到工作记忆中之后,向用户呈现联系人列表或通信工具。在又一个非限制性示例中,所公开的系统可以在(例如,基于在编码状态期间用户的聚焦注意力被引导向信用卡号码)确定用户可能正在试图对支付信息进行编码之后、和/或在(例如,基于检测到用户在检索状态期间位于电子商务网站的支付页面上)确定用户可能正在试图回忆支付信息之后,向用户呈现数字钱包或另一形式的支付信息。在一些示例中,所公开的系统可以通过自动填写支付信息和/或通过使用户能够通过单次动作(例如单次点击)填写支付信息,来降低填写支付信息的摩擦。

81.在又一非限制性示例中,所公开的系统可以在(例如,基于在检索阶段期间用户的聚焦注意力被导向单词)确定用户可能正在试图检索单词的定义之后,向用户呈现词典。在其他非限制性示例中,所公开的系统可以在(例如,基于在编码阶段期间用户的聚焦注意力被导向地址)确定用户可能正在试图对地址进行编码之后、和/或在(例如,基于在检索阶段期间用户的聚焦注意力被导向地址)确定用户可能正在试图从用户的长期记忆中回忆地址之后,向用户呈现地址簿。在另一个非限制性示例中,所公开的系统可以在确定用户处于与用户最后一次访问项目的环境或情况相似的环境或情况,并且用户正在试图从长期记忆中检索信息之后,呈现用户先前访问的项目(例如,说明手册)。

82.在一些非限制性示例中,所公开的系统可以在确定用户在编码状态期间正在与先前不认识的人联系之后,自动存储用户的联系信息(例如,姓名、标题、照片或事件细节)。以后,在用户处于同一人在场并且处于检索状态时,所公开的系统可以自动向用户呈现所存储的联系信息。在另一非限制性示例中,所公开的系统可以在(例如,基于在重演状态期间

用户的聚焦注意力被导向单词)确定用户可能正在试图对新词汇单词进行编码之后,自动将新词汇单词存储到词典中。

83.在另一非限制性示例中,所公开的系统可以在(例如,通过检测编码状态期间用户的视场角内事件的细节,例如日期或时间)确定用户可能正在对关于事件的信息进行编码之后,在日历工具中自动创建会议、约会或提醒。在另一非限制性示例中,所公开的系统可以通过在从搜索状态转换期间标记用户视场角中或用户拥有的物品来自动追踪关于用户经常搜索的物品(例如,钥匙、眼镜和电话)的细节。所公开的系统以后可以(例如,当用户在类似的位置或时间处于检索状态并且物品不被用户拥有时)自动提供关于物品的细节。

84.本公开的实施例可以包括各种类型的人工现实系统、或结合各种类型的人工现实系统来实现。人工现实是在呈现给用户之前已经以某种方式进行了调整的现实形式,人工现实例如可以包括虚拟现实、增强现实、混合现实(mixed reality)、混杂现实(hybrid reality)、或它们的某种组合和/或衍生物。人工现实内容可以包括完全计算机生成内容、或与所采集的(例如,真实世界的)内容相结合的计算机生成内容。人工现实内容可以包括视频、音频、触觉反馈、或它们的某种组合,以上中的任何一种可以在单个通道或多个通道中呈现(诸如对观看者产生三维(three-dimensional,3d)效果的立体视频)。此外,在一些实施例中,人工现实还可以与应用、产品、附件、服务或它们的某种组合相关联,这些应用、产品、附件、服务或它们的某种组合例如用于在人工现实中创建内容,和/或以其他方式用于人工现实中(例如,在人工现实中执行活动)。

85.人工现实系统可以以各种不同的形状要素和配置来实现。一些人工现实系统可以被设计成在没有近眼显示器(near-eye display,ned)的情况下工作。其他人工现实系统可以包括ned,该ned还提供对现实世界的可见性(例如,图11中的增强现实系统1100),或者使用户在视觉上沉浸在人工现实中(例如,图12中的虚拟现实系统1200)。尽管一些人工现实设备可以是独立的系统,但其他人工现实设备可以与外部设备通信和/或配合以向用户提供人工现实体验。这种外部设备的示例包括手持控制器、移动设备、台式计算机、由用户穿戴的设备、由一个或多个其他用户穿戴的设备、和/或任何其他合适的外部系统。

86.转到图11,增强现实系统1100可以包括具有框架1110的眼镜设备1102,该框架被配置为将左显示设备1115(a)和右显示设备1115(b)保持在用户眼睛的前方。显示设备1115(a)和显示设备1115(b)可以一起或独立地动作,以向用户呈现一幅图像或一系列图像。尽管增强现实系统1100包括两个显示器,但是本公开的实施例可以在具有单个ned或多于两个ned的增强现实系统中实现。

87.在一些示例中,增强现实系统1100可以包括一个或多个传感器,例如传感器1140。传感器1140可以响应于增强现实系统1100的运动而生成测量信号,且大体上可以位于框架1110的任何部位上。传感器1140可以表示各种不同感测机构中的一者或多者,例如位置传感器、惯性测量单元(inertial measurement unit,imu)、深度摄像头组件、结构光发射器和/或检测器、或它们的任意组合。在一些示例中,增强现实系统1100可以包括或不包括传感器1140,或者可以包括一个以上的传感器。在传感器1140包括imu的示例中,该imu可以基于来自传感器1140的测量信号生成校准数据。传感器1140的示例可以包括但不限于:加速度计、陀螺仪、磁力计、检测运动的其它合适类型的传感器、用于imu的误差校正的传感器、或它们的某种组合。

88.在一些示例中,增强现实系统1100还可以包括传声器阵列,该传声器阵列具有多个声学转换器1120(a)至1120(j),它们被统称为声学转换器1120。声学转换器1120可以表示检测由声波引起的气压变化的转换器。每个声学转换器1120可以被配置为检测声音并将检测到的声音转换成电子格式(例如,模拟格式或数字格式)。图11中的传声器阵列例如可以包括十个声学转换器:可以被设计为放置在用户的对应耳朵内部的1120(a)和1120(b),可以被定位在框架1110上的各个位置处的声学转换器1120(c)、1120(d)、1120(e)、1120(f)、1120(g)和1120(h),和/或可以被定位在对应的颈带115上的声学转换器1120(i)和1120(j)。

89.在一些示例中,声学转换器1120(a)至1120(j)中的一个或多个声学转换器可以用作输出转换器(例如,扬声器)。例如,声学转换器1120(a)和/或1120(b)可以是耳塞或任何其他合适类型的耳机(headphone)或扬声器。

90.传声器阵列中的各声学转换器1120的配置可以改变。尽管增强现实系统1100在图11中被显示为具有十个声学转换器1120,但声学转换器1120的数量可以大于或小于十个。在一些示例中,使用更多数量的声学转换器1120可以增加收集到的音频信息的量和/或音频信息的灵敏度和准确性。相比之下,使用较少数量的声学转换器1120可以降低相关联的控制器1150处理收集到的音频信息所需的计算能力。另外,传声器阵列中的各个声学转换器1120的位置可以改变。例如,声学转换器1120的位置可以包括用户身上的限定位置、框架1110上的限定坐标、与每个声学转换器1120相关联的方位、或它们的某种组合。

91.声学转换器1120(a)和1120(b)可以被定位在用户耳朵的不同部位上,诸如外耳(pinna)后面、耳屏后面、和/或耳廓(auricle)或耳窝内。或者,除了耳道内的声学转换器1120之外,在耳朵上或耳朵周围还可以存在附加的声学转换器1120。将声学转换器1120定位在用户的耳道附近可以使传声器阵列能够收集关于声音如何到达耳道的信息。通过将各声学转换器1120中的至少两个声学转换器定位在用户头部的两侧(例如,作为双耳传声器),增强现实设备1100可以模拟双耳听觉并采集用户头部周围的3d立体声场。在一些示例中,声学转换器1120(a)和1120(b)可以经由有线连接1130连接到增强现实系统1100,而在其它示例中,声学转换器1120(a)和1120(b)可以经由无线连接(例如,蓝牙连接)连接到增强现实系统1100。在另一些示例中,声学转换器1120(a)和1120(b)可以完全不与增强现实系统1100结合使用。

92.框架1110上的多个声学转换器1120可以以各种不同的方式而被定位,所述方式包括沿着镜腿(temple)的长度、跨过鼻梁架(bridge)、在显示设备1115(a)和显示设备1115(b)的上方或下方、或它们的某种组合。声学转换器1120还可以被定向为使得传声器阵列能够检测佩戴了增强现实系统1100的用户周围的宽范围方向上的声音。在一些示例中,可以在增强现实系统1100的制造期间执行优化过程,以确定各个声学转换器1120在传声器阵列中的相对定位。

93.在一些示例中,增强现实系统1100可以包括或连接到诸如颈带115的外部设备(例如,配对设备)。颈带115通常表示任何类型或形式的配对设备。因此,对颈带115的以下论述也可以应用于各种其他的配对设备,例如充电盒、智能手表、智能电话、腕带、其他可穿戴设备、手持控制器、平板计算机、膝上型计算机、其他外部计算设备等。

94.如图所示,颈带115可以经由一个或多个连接器而耦接到眼镜设备1102。这些连接

器可以是有线的或无线的,并且可以包括电子部件和/或非电子部件(例如,结构部件)。在一些情况下,眼镜设备1102和颈带115可以在它们之间没有任何有线连接或无线连接的情况下独立地操作。尽管图11示出了眼镜设备1102和颈带115中的部件位于眼镜设备1102和颈带115上的示例位置处,但这些部件可以位于眼镜设备1102和/或颈带115上的其它位置和/或以不同的方式分布在该眼镜设备和/或该颈带上。在一些示例中,眼镜设备1102和颈带115中的部件可以位于一个或多个附加的外围设备上,该一个或多个附加的外围设备与眼镜设备1102、颈带115、或它们的某种组合配对。

95.将外部设备(诸如颈带115)与增强现实眼镜设备配对可以使该眼镜设备能够实现一副眼镜的形状要素,同时仍然为扩展的能力提供足够的电池电量和计算能力。增强现实系统1100的电池电量、计算资源和/或附加特征中的一些或全部可以由配对设备来提供,或者在配对设备与眼镜设备之间共享,从而总体上降低眼镜设备的重量、热量分布和形状要素,同时仍然保持所期望的功能。例如,由于与用户在其头部上承受的相比,他们可以在其肩部上承受更重的重量负担,因此颈带115可以允许原本将被包括在眼镜设备上的部件包括在颈带115中。颈带115还可以具有较大的表面积,以通过该较大的表面积将热量扩散和散发到周围环境。因此,与在独立眼镜设备上以其它方式可行的电池电量和计算能力相比,颈带115可以允许更大的电池电量和更强的计算能力。由于颈带115中携载的重量可以比眼镜设备1102中携载的重量对用户的侵害小,因此,与用户忍受佩戴重的独立眼镜设备相比,用户可以忍受更长时间佩戴较轻眼镜设备且携带或佩戴配对设备,从而使用户能够将人工现实环境更充分地融入到他们的日常活动中。

96.颈带115可以与眼镜设备1102通信地耦接,和/或通信地耦接至其它设备。这些其它设备可以向增强现实系统1100提供某些功能(例如,追踪、定位、深度图绘制(depth mapping)、处理、存储等)。在图11的示例中,颈带115可以包括两个声学转换器(例如,声学转换器1120(i)和1120(j)),该两个声学转换器是传声器阵列的一部分(或者潜在地形成它们自己的传声器子阵列)。颈带115还可以包括控制器1125和电源1135。

97.颈带115中的声学转换器1120(i)和1120(j)可以被配置为检测声音并将检测到的声音转换为电子格式(模拟或数字)。在图11的示例中,声学转换器1120(i)和1120(j)可以被定位在颈带115上,从而增加了颈带的声学转换器1120(i)和1120(j)与被定位在眼镜设备1102上的其它声学转换器1120之间的距离。在一些情况下,增加传声器阵列中的各声学转换器1120之间的距离可以提高经由该传声器阵列执行的波束成形的准确性。例如,如果声学转换器1120(c)和1120(d)检测到声音,且声学转换器1120(c)与1120(d)之间的距离例如大于声学转换器1120(d)与1120(e)之间的距离,则所确定的检测到的声音的源位置可以比当该声音被声学转换器1120(d)和1120(e)检测到时更准确。

98.颈带115中的控制器1125可以对由颈带115和/或增强现实系统1100上的各传感器生成的信息进行处理。例如,控制器1125可以对来自传声器阵列的、描述由该传声器阵列检测到的声音的信息进行处理。对于每个检测到的声音,控制器1125可以执行波达方向(direction-of-arrival,doa)估计,以估计检测到的声音从哪个方向到达传声器阵列。当传声器阵列检测到声音时,控制器1125可以用该信息填充音频数据集。在增强现实系统1100包括惯性测量单元的示例中,控制器1125可以根据位于眼镜设备1102上的imu计算所有惯性和空间计算。连接器可以在增强现实系统1100与颈带115之间、以及在增强现实系统

1100与控制器1125之间传送信息。该信息可以是光学数据形式、电子数据形式、无线数据形式、或任何其它可传输的数据形式。将对增强现实系统1100所生成的信息的处理转移到颈带115,可以减少眼镜设备1102中的重量和热量,以使该眼镜设备对用户而言更舒适。

99.颈带115中的电源1135可以向眼镜设备1102和/或颈带115提供电力。电源1135可以包括但不限于:锂离子电池、锂聚合物电池、一次性锂电池(primary lithium batteries)、碱性电池、或任何其他形式的电力存储器。在一些情况下,电源1135可以是有线电源。将电源1135包括在颈带115上而不是眼镜设备1102上可以有助于更好地分布由电源1135产生的重量和热量。

100.如所提到的,一些人工现实系统可以使用虚拟体验来大体上代替用户对真实世界的感官知觉中的一个或多个感官知觉,而不是将人工现实与真实现实混合。这种类型的系统的一个示例是大部分或完全覆盖用户视场角的头戴式显示系统,例如图12中的虚拟现实系统1200。虚拟现实系统1200可以包括前部刚性体1202和被成形为适合围绕用户头部的带124。虚拟现实系统1200还可以包括输出音频转换器126(a)和126(b)。此外,尽管图12中未示出,但前部刚性体1202可以包括一个或多个电子元件,该一个或多个电子元件包括一个或多个电子显示器、一个或多个惯性测量单元(imu)、一个或多个追踪发射器或检测器、和/或用于生成人工现实体验的任何其它合适的设备或系统。

101.人工现实系统可以包括各种类型的视觉反馈机制。例如,增强现实系统1100中和/或虚拟现实系统1200中的显示设备可以包括:一个或多个液晶显示器(liquid crystal display,lcd)、一个或多个发光二极管(light emitting diode,led)显示器、一个或多个微型led显示器、一个或多个有机led(organic led,oled)显示器、一个或多个数字光投影(digital light project,dlp)微型显示器、一个或多个硅基液晶(liquid crystal on silicon,lcos)微型显示器、和/或任何其它合适类型的显示屏。这些人工现实系统可以包括用于双眼的单个显示屏,或者可以为每只眼睛提供一个显示屏,这可以为变焦调整或为校正用户的屈光不正而提供额外的灵活性。这些人工现实系统中的一些人工现实系统还可以包括多个光学子系统,这些光学子系统具有一个或多个透镜(例如,凹透镜或凸透镜、菲涅耳透镜、可调整的液体透镜等),用户可以透过该一个或多个透镜观看显示屏。这些光学子系统可以用于各种目的,包括准直(例如,使对象显现在比其物理距离更远的距离处)、放大(例如,使对象显现得比其实际尺寸更大)、和/或传递光(例如,传递到观看者的眼睛)。这些光学子系统可以用于直视型架构(non-pupil-forming architecture)(例如,直接对光进行准直但会产生所谓的枕形失真(pincushion distortion)的单透镜配置)和/或非直视型架构(pupil-forming architecture)(例如,产生所谓的桶形失真以抵消枕形失真的多透镜配置)。

102.除了使用显示屏之外,或代替使用显示屏,本文所描述的人工现实系统中的一些人工现实系统可以包括一个或多个投影系统。例如,增强现实系统1100和/或虚拟现实系统1200中的显示设备可以包括微型led投影仪,该微型led投影仪将光投射(例如,使用波导)到显示设备中,该显示设备诸如为允许环境光通过的透明组合透镜。显示设备可以朝向用户的瞳孔折射所投射的光,并且可以使用户能够同时观看人工现实内容和真实世界这两者。显示设备可以使用各种不同光学部件中的任何光学部件来实现该目的,这些不同光学部件包括波导部件(例如,全息元件、平面元件、衍射元件、偏振元件、和/或反射波导元件)、

光操纵表面和元件(诸如衍射元件和光栅、反射元件和光栅、折射元件和光栅)、耦合元件等。人工现实系统还可以配置有任何其它合适类型或形式的图像投影系统,例如用于虚拟视网膜显示器的视网膜投影仪。

103.本文所描述的人工现实系统还可以包括各种类型的计算机视觉部件和子系统。例如,增强现实系统1100和/或虚拟现实系统1200可以包括:一个或多个光学传感器,例如二维(two-dimensional,2d)摄像头或3d摄像头、结构光发射器和检测器、飞行时间深度传感器、单光束测距仪或扫描激光测距仪、3d lidar传感器、和/或任何其他合适类型或形式的光学传感器。人工现实系统可以对来自这些传感器中的一个或多个传感器的数据进行处理,以识别用户的位置、绘制真实世界的地图、向用户提供与真实世界周围环境有关的背景、和/或执行各种其它功能。

104.本文所描述的人工现实系统还可以包括一个或多个输入和/或输出音频转换器。输出音频转换器可以包括音圈扬声器、带式扬声器、静电式扬声器、压电式扬声器、骨传导转换器、软骨传导转换器、耳屏振动转换器、和/或任何其它合适类型或形式的音频转换器。类似地,输入音频转换器可以包括电容式传声器、动态传声器、带式传声器、和/或任何其它类型或形式的输入转换器。在一些示例中,对于音频输入和音频输出这两者,可以使用单个转换器。

105.在一些示例中,本文所描述的人工现实系统还可以包括触觉(tactile)(即触感(haptic))反馈系统,该触觉反馈系统可以结合到头饰、手套、服装、手持控制器、环境设备(例如椅子、地板垫等)、和/或任何其它类型的设备或系统中。触觉反馈系统可以提供各种类型的皮肤反馈,这些类型的皮肤反馈包括振动、推力、牵拉、质地和/或温度。触觉反馈系统还可以提供各种类型的动觉反馈,诸如运动和顺应性。可以使用电机、压电式致动器、流体系统、和/或各种其它类型的反馈机构来实现触觉反馈。触觉反馈系统可以独立于其它人工现实设备而实现,在其它人工现实设备内实现,和/或结合其它人工现实设备来实现。

106.通过提供触觉感知、听觉内容和/或视觉内容,人工现实系统可以在各种背景和环境中创建完整的虚拟体验或增强用户的真实世界体验。例如,人工现实系统可以辅助或扩展用户在特定环境中的知觉、记忆或认知。一些系统可以增强用户与真实世界中的其他人的交互,或者可以实现与虚拟世界中的其他人的更沉浸式的交互。人工现实系统也可以用于教育目的(例如,用于学校、医院、政府机构、军事机构、企业等中的教学或训练)、娱乐目的(例如,用于玩视频游戏、听音乐、观看视频内容等)、和/或用于可接入性目的(例如,用作助听器、视觉辅助器等)。本文所公开的示例可以在这些背景和环境中的和/或在其它背景和环境中的一个或多个背景和环境中实现或增强用户的人工现实体验。

107.一些增强现实系统可以使用被称为“同时定位与地图构建”(“simultaneous location and mapping”,slam)的技术,来构建用户环境和/或设备环境的地图。slam地图构建和定位识别技术可以涉及各种硬件和软件工具,这些硬件和软件工具可以创建或更新环境的地图,同时保持追踪用户在所地图构建的环境内的位置。slam可以使用许多不同类型的传感器,来创建地图并确定用户在地图中的位置。

108.slam技术例如可以实现光学传感器,以确定用户的位置。无线电设备(包括wi-fi、蓝牙、全球定位系统(global positioning system,gps)、蜂窝、或其他通信设备)也可以用于确定用户相对于无线电收发器或收发器组(例如,wi-fi路由器或gps卫星组)的位置。声

学传感器(例如,传声器阵列、或2d或3d声纳传感器)也可以用于确定用户在环境中的位置。增强现实设备和虚拟现实设备(例如,图11中的系统1100和图12中的系统1200)可以结合这些类型的传感器中的任何传感器或全部传感器,来执行诸如创建和持续更新用户的当前环境的地图等slam操作。在本文所描述的多个实施例中的至少一些示例中,由这些传感器生成的slam数据可以称为“环境数据”并且可以指示用户的当前环境。这些数据可以存储在本地或远程数据存储区(例如,云数据存储区)中,并且可以根据需要而提供给用户的ar/vr设备。

109.如所提到的,人工现实系统1100和1200可以与各种其他类型的设备一起使用,以提供更引人入盛的人工现实体验。这些设备可以是具有多个转换器的触觉接口,这些转换器提供触觉反馈和/或收集用户与环境的交互有关的触觉信息。本文所公开的人工现实系统可以包括各种类型的触觉接口,这些类型的触觉接口检测或传送各种类型的触觉信息,这些类型的触觉信息包括触觉反馈(例如,用户经由皮肤中的神经而觉察到的反馈,该反馈也可以称为皮肤反馈)和/或动觉反馈(例如,用户经由位于肌肉、关节和/或肌腱中的感受器而觉察到的反馈)。

110.触觉反馈可以通过定位在用户环境(例如,椅子、桌子、地板等)内的接口和/或用户可以佩戴或携带的物品(例如,手套、腕带等)上的接口来提供。作为示例,图13示出了可穿戴手套(触觉设备1310)和腕带(触觉设备1320)形式的振动触觉系统1300。触觉设备1310和触觉设备1320被示出为可穿戴设备的示例,其分别包括柔性的可穿戴纺织材料1330,柔性的可穿戴纺织材料1330被成形和配置为抵靠用户的手和手腕而定位。本公开也包括可以被成形和配置为抵靠其他人体部位(例如,手指、手臂、头部、躯干、足部、或腿)而定位的振动触觉系统。作为示例而非限制,根据本公开各种实施例的振动触觉系统也可以是手套、头带、臂带、袖子、头罩、袜子、衬衫、或裤子等其他可能的形式。在一些示例中,术语“纺织”可以包括任何柔性的可穿戴的材料,包括纺织织物、非纺织织物、皮革、布、柔性聚合物材料、复合材料等。

111.一个或多个振动触觉设备1340可以被定位成至少部分地位于在振动触觉系统1300的纺织材料1330中形成的一个或多个相应的口袋内。振动触觉设备1340可以被定位在适当位置处以向振动触觉系统1300的用户提供振动知觉(例如,触觉反馈)。例如,振动触觉设备1340可以定位成抵靠用户的一个或多个手指(finger)、拇指或手腕,如图13所示。在一些示例中,振动触觉设备1340可以是足够柔性的,以顺应用户的一个或多个相应身体部位,或随着用户的一个或多个相应身体部位弯曲。

112.用于向多个振动触觉设备1340施加电压以用于激活这些振动触觉设备的电源1350(例如,电池)可以电耦接到(例如,经由导线1352电耦接到)这些振动触觉设备1340。在一些示例中,多个振动触觉设备1340中的每个振动触觉设备可以独立地电耦接到电源1350以用于单独激活。在一些示例中,处理器1360可以可操作地耦接到电源1350,并且被配置(例如,被编程)为控制对多个振动触觉设备1340的激活。

113.振动触觉系统1300可以以各种方式实现。在一些示例中,振动触觉系统1300可以是具有多个集成子系统和多个部件以独立于其他设备和系统运行的独立系统。作为另一个示例,振动触觉系统1300可以被配置为与另一设备或系统1370交互。例如,在一些示例中,振动触觉系统1300可以包括用于接收信号和/或向该另一设备或系统1370发送信号的通信

接口1380。该另一设备或系统1370可以是移动设备、游戏控制台、人工现实(例如,虚拟现实、增强现实、混合现实)设备、个人计算机、平板计算机、网络设备(例如,调制解调器、路由器等)、手持控制器等。通信接口1380可以经由无线(例如,wi-fi、蓝牙、蜂窝、无线电等)链路或有线链路实现振动触觉系统1300与该另一设备或系统1370之间的通信。如果存在通信接口1380,则该通信接口可以与处理器1360通信,例如以向处理器1360提供信号来激活或去激活多个振动触觉设备1340中的一个或多个振动触觉设备。

114.振动触觉系统1300可以可选地包括其他子系统和部件,例如多个触摸感应垫1390、多个压力传感器、多个运动传感器、多个位置传感器、多个照明元件、和/或多个用户接口元件(例如,开/关按钮、振动控制元件等)。在使用期间,振动触觉设备1340可以被配置为出于各种不同的原因而被激活,例如响应于用户与用户接口元件的交互、来自运动传感器或位置传感器的信号、来自触摸感应垫1390的信号、来自压力传感器的信号、来自该另一设备或系统1370的信号等而被激活。

115.尽管电源1350、处理器1360和通信接口1380在图13中被示出为被定位在触觉设备1320中,但本公开不限于此。例如,电源1350、处理器1360或通信接口1380中的一者或多者可以被定位在触觉设备1310内或另一个可穿戴织物内。

116.触觉可穿戴物(例如,在图13中示出和结合图13所描述的那些)可以在各种类型的人工现实系统和环境中实现。图14显示了示例人工现实环境1400,该人工现实环境包括一个头戴式虚拟现实显示器和两个触觉设备(即,手套),并且在其他示例中,任何数量的这些部件和其他部件、和/或这些部件和其他部件的任何组合可以被包括在人工现实系统中。例如,可以存在多个头戴式显示器,每个头戴式显示器具有相关联的触觉设备,每个头戴式显示器和每个触觉设备与同一控制台、便携式计算设备、或其他计算系统通信。

117.头戴式显示器1402概括地表示任何类型或形式的虚拟现实系统,例如图12中的虚拟现实系统1200。触觉设备144概括地表示由人工现实系统的用户穿戴的任何类型或形式的可穿戴设备,该可穿戴设备向用户提供触觉反馈,以给予用户他或她正与虚拟对象物理接触的感知。在一些示例中,触觉设备144可以通过向用户施加振动、运动和/或推力来提供触觉反馈。例如,触觉设备144可以限制或增强用户的动作。给出一特定的示例,触觉设备144可以限制用户的手向前移动,使得用户感知到他或她的手已经与虚拟壁物理接触。在该特定示例中,触觉设备内的一个或多个致动器可以通过将流体泵入触觉设备的可膨胀气囊中来实现物理移动限制。在一些示例中,用户还可以使用触觉设备144来向控制台发送动作请求。动作请求的示例包括但不限于,启动应用程序和/或结束应用程序的请求、和/或执行应用程序内的特定动作的请求。

118.尽管触觉接口可以与虚拟现实系统(如图14所示)一起使用,但触觉接口也可以与增强现实系统(如图15所示)一起使用。图15是用户1510与增强现实系统1500交互的立体图。在该示例中,用户1510可以佩戴一副增强现实眼镜1520,该副增强现实眼镜可以具有一个或多个显示器1522并且与触觉设备1530配对。在该示例中,触觉设备1530可以是腕带,该腕带包括多个带元件1532和将这些带元件1532彼此连接的拉伸机构1534。

119.多个带元件1532中的一个或多个带元件可以包括适于提供触觉反馈的任何类型或形式的致动器。例如,多个带元件1532中的一个或多个带元件可以被配置为提供各种类型的皮肤反馈中的一种或多种类型的皮肤反馈,这些类型的皮肤反馈包括振动、推力、牵

拉、质地和/或温度。为了提供这种反馈,多个带元件1532可以包括各种类型的致动器中的一种或多种类型的致动器。在一个示例中,多个带元件1532中的每个带元件可以包括振动触觉器(vibrotactor)(例如,振动触觉致动器),该振动触觉器被配置为联合地或独立地振动,以向用户提供各种类型的触觉知觉中的一种或多种类型的触觉知觉。替代地,仅单个带元件或多个带元件的子集可以包括振动触觉器。

120.触觉设备1310、1320、144和1530可以包括任何合适数量和/或类型的触觉转换器、传感器和/或反馈机构。例如,触觉设备1310、1320、144和1530可以包括一个或多个机械式转换器、一个或多个压电式转换器、和/或一个或多个流体转换器。触觉设备1310、1320、144和1530也可以包括一起或独立工作的不同类型和形式的转换器的各种组合,以增强用户的人工现实体验。在一个示例中,触觉设备1530的多个带元件1532中的每个带元件可以包括振动触觉器(例如,振动触觉致动器),该振动触觉器被配置为联合地或独立地振动,以向用户提供各种类型的触觉知觉中的一种或多种触觉知觉。

121.在一些示例中,本文所描述的系统还可以包括眼动追踪子系统,该眼动追踪子系统被设计为识别和追踪用户眼睛的各种特性,例如用户的注视方向。在一些示例中,词语“眼动追踪”可以指这样过程:眼睛的位置、方位和/或运动通过该过程来进行测量、检测、感测、确定和/或监测。所公开的系统可以以各种不同的方式测量眼睛的位置、方位和/或运动,这些不同的方式包括通过使用各种基于光学的眼动追踪技术、基于超声波的眼动追踪技术等。眼动追踪子系统可以以多种不同的方式配置,并且可以包括各种不同的眼动追踪硬件部件或其他计算机视觉部件。例如,眼动追踪子系统可以包括各种不同的光学传感器,例如二维(2d)摄像头或3d摄像头、飞行时间深度传感器、单波束测距仪或扫描激光测距仪、3d激光雷达(lidar)传感器、和/或任何其他合适类型或形式的光学传感器。在该示例中,处理子系统可以对来自这些传感器中的一个或多个传感器的数据进行处理,以测量、检测、确定、和/或以其他方式监测用户眼睛的位置、方位和/或运动。

122.图16是示例性系统1600的图示,该示例性系统包括能够追踪用户眼睛的眼动追踪子系统。如图16中所描绘的,系统1600可以包括光源1602、光学子系统164、眼动追踪子系统166和/或控制子系统168。在一些示例中,光源1602可以生成用于图像(例如,该图像将呈现给观看者的眼睛1601)的光。光源1602可以表示各种合适的设备中的任何一种。例如,光源1602可以包括二维投影仪(例如,lcos显示器)、扫描源(例如,扫描激光器)、或其他设备(例如,lcd、led显示器、oled显示器、有源矩阵oled显示器(active-matrix oled display,amoled)、透明oled显示器(transparent oled display,toled)、波导、或能够生成用于向观察者呈现图像的光的一些其他显示器)。在一些示例中,该图像可以表示虚拟图像,该虚拟图像可以指由来自空间的一点的光线的表观发散(apparent divergence)形成的光学图像,而不是指由光线的实际发散形成的图像。

123.在一些示例中,光学子系统164可以接收由光源1602产生的光,并且基于所接收到的光生成包括该图像的会聚光1620。在一些示例中,光学子系统164可以包括可能与致动器和/或其他设备组合的任何数量的透镜(例如,菲涅尔透镜、凸透镜、凹透镜)、光圈、滤光片、反射镜、棱镜、和/或其他光学部件。具体地,致动器和/或其他设备可以平移和/或转动多个光学部件中的一个或多个光学部件以改变会聚光1620的一个或多个方面。此外,各种机械式联接件可以用于以任何合适的组合保持光学部件的相对间隔和/或方位。

124.在一个示例中,眼动追踪子系统166可以生成如下追踪信息:该追踪信息指示观看者的眼睛1601的注视角度。在该示例中,控制子系统168可以至少部分地基于该追踪信息来控制光学子系统164的各方面(例如,会聚光1620的入射角)。此外,在一些示例中,控制子系统168可以存储历史追踪信息(例如,在给定持续时间(例如前一秒或其一小部分)内的追踪信息的历史)并利用该历史追踪信息来预期眼睛1601的注视角度(例如,眼睛1601的视轴和解剖轴之间的角度)。在一些示例中,眼动追踪子系统166可以检测从眼睛1601的某个部分(例如,角膜、虹膜、或瞳孔等)发出的辐射,以确定眼睛1601的当前注视角度。在其他示例中,眼动追踪子系统166可以采用波前传感器来追踪瞳孔的当前位置。

125.可以使用任何数量的技术来追踪眼睛1601。一些技术可以涉及使用红外光照射眼睛1601,并使用至少一个被调谐为对红外光敏感的光学传感器来测量反射。可以对关于红外光如何从眼睛1601反射的信息进行分析,以确定一个或多个眼睛特征(例如,角膜、瞳孔、虹膜、和/或视网膜血管)的一个或多个位置、一个或多个方位、和/或一个或多个运动。

126.在一些示例中,可以对由眼动追踪子系统166的传感器采集的辐射进行数字化(即,转换成电子信号)。此外,传感器可以将该电子信号的数字表示发送到一个或多个处理器(例如,与包括眼动追踪子系统166的设备相关联的处理器)。眼动追踪子系统166可以包括各种不同配置的各种传感器中的任何一种传感器。例如,眼动追踪子系统166可以包括对红外辐射作出反应的红外探测器。红外探测器可以是热探测器、光子探测器、和/或任何其他合适类型的探测器。热探测器可以包括对入射红外辐射的热效应作出反应的探测器。

127.在一些示例中,一个或多个处理器可以对由眼动追踪子系统166的一个或多个传感器生成的数字表示进行处理,以追踪眼睛1601的移动。在另一示例中,这些处理器可以通过执行由存储在非暂态存储器上的计算机可执行指令表示的算法,来追踪眼睛1601的移动。在一些示例中,片上逻辑(例如,专用集成电路或asic)可以用于执行这些算法的至少一部分。如所提到的,眼动追踪子系统166可以被编程为使用一个或多个传感器的输出来追踪眼睛1601的移动。在一些示例中,眼动追踪子系统166可以对由传感器生成的数字表示进行分析,以从反射的变化中提取眼睛转动信息。在一个示例中,眼动追踪子系统166可以使用角膜反射或闪烁(glint)(也称为浦肯野(purkinje)图像)和/或眼睛的瞳孔1622的中心作为随时间追踪的特征。

128.在一些示例中,眼动追踪子系统166可以使用眼睛的瞳孔1622的中心、和红外光或近红外光、非准直光来产生角膜反射。在这些示例中,眼动追踪子系统166可以使用眼睛的瞳孔1622的中心和角膜反射之间的矢量来计算眼睛1601的注视方向。在一些示例中,所公开的系统可以在追踪用户的眼睛之前,(使用例如监督技术或无监督技术)对个体执行校准过程。例如,校准过程可以包括:引导用户看向显示在显示器上的一个或多个点,同时眼动追踪系统记录与每个注视位置(其与每个点相关联)相对应的值。

129.在一些示例中,眼动追踪子系统166可以使用两种类型的红外和/或近红外(也称为主动光)眼动追踪技术:亮瞳眼动追踪和暗瞳眼动追踪,这可以基于照明源相对于所使用的光学元件的位置来区分。如果照明与光路同轴,则眼睛1601可以用作回射器(retroreflector),因为光从视网膜上反射,从而产生类似于摄影中的红眼效果的亮瞳效果。如果照明源偏离光路,则眼睛的瞳孔1622可能看起来很暗,因为从视网膜的回射被引导为远离传感器。在一些示例中,亮瞳追踪可以产生更大的虹膜/瞳孔对比度,从而允许具有

虹膜色素沉着的更稳健的眼动追踪,并且可以减少干扰(例如,由睫毛和其他模糊特征引起的干扰)。亮瞳追踪也可以允许在从完全黑暗到非常明亮的环境的照明条件下进行追踪。

130.在一些示例中,控制子系统168可以对光源1602和/或光学子系统164进行控制,以减少图像的可能由眼睛1601引起或受眼睛1601影响的光学像差(例如,色差和/或单色像差)。在一些示例中,如上所述,控制子系统168可以使用来自眼动追踪子系统166的追踪信息来执行这种控制。例如,在控制光源1602时,控制子系统168可以(例如通过图像渲染)改变由光源1602产生的光,以对图像进行修改(例如,预失真),从而减少该图像的由眼睛1601引起的像差。

131.所公开的系统可以追踪瞳孔的位置和相对尺寸这两者(例如,因瞳孔放大和/或收缩)。在一些示例中,对于不同类型的眼睛,用于检测和/或追踪瞳孔的眼动追踪设备和部件(例如,传感器和/或源)可以不同(或者可以被不同地校准)。例如,对于不同颜色的眼睛、和/或不同瞳孔类型和/或尺寸等的眼睛,传感器的频率范围可以不同(或者可以被单独校准)。就这一点而言,本文所描述的各种眼动追踪部件(例如,红外源和/或传感器)可能需要针对每个单独的用户和/或眼睛进行校准。

132.所公开的系统可以在进行或不进行眼科矫正(例如,由用户佩戴的隐形眼镜提供的眼科矫正)的情况下追踪双眼。在一些示例中,可以直接将眼科矫正元件(例如,可调节透镜)结合到本文所描述的人工现实系统中。在一些示例中,用户眼睛的颜色可能使对对应的眼动追踪算法的修改成为必要。例如,眼动追踪算法可能需要至少部分地基于棕色眼睛和例如蓝色眼睛之间的不同颜色对比度进行修改。

133.图17是图16所示的眼动追踪子系统的各个方面的更详细的说明。如该图所示,眼动追踪子系统1700可以包括至少一个源174和至少一个传感器176。源174概括地表示能够发射辐射的任何类型或形式的元件。在一个示例中,源174可以产生可见辐射、红外辐射和/或近红外辐射。在一些示例中,源174可以朝向用户的眼睛1702辐射电磁波谱的非准直的红外部分和/或近红外部分。源174可以利用各种采样率和采样速度。例如,所公开的系统可以使用具有较高采样率的源,以便采集用户的眼睛1702的注视眼动,和/或以便正确测量用户的眼睛1702的扫视动态。如上所提及的,可以使用任何类型或形式的眼动追踪技术来追踪用户的眼睛1702,这些类型或形式的技术包括基于光学的眼动追踪技术、基于超声波的眼动追踪技术等。

134.传感器176概括地表示能够检测辐射(例如,从用户的眼睛1702反射的辐射)的任何类型或形式的元件。传感器176的示例包括但不限于:电荷耦合器件(charge coupled device,ccd)、光电二极管阵列、和/或基于互补金属氧化物半导体(complementary metal-oxide-semiconductor,cmos)的传感器器件等。在一个示例中,传感器176可以表示具有预定参数的传感器,这些预定参数包括但不限于:动态分辨率范围、线性度、和/或专门为眼动追踪而选择和/或设计的其他特性。

135.如上所详述的,眼动追踪子系统1700可以产生一个或多个闪烁。如上所详述的,闪烁173可以表示从用户眼睛的结构对辐射(例如,来自红外源(例如,源174)的红外辐射)的反射。在各种示例中,可以使用由处理器(人工现实设备内部或外部的处理器)执行的眼动追踪算法来追踪闪烁173和/或用户的瞳孔。例如,人工现实设备可以包括:处理器和/或存储设备,以便在本地执行眼动追踪;和/或收发器,以用于发送和接收在外部设备(例如,移

动电话、云服务器、或其他计算设备)上执行眼动追踪所需的数据。

136.图17显示了由眼动追踪子系统(例如,眼动追踪子系统1700)采集的示例图像175。在该示例中,图像175可以包括用户的瞳孔178和该瞳孔附近的闪烁1710。在一些示例中,可以使用基于人工智能的算法(例如,基于计算机视觉的算法)来识别瞳孔178和/或闪烁1710。在一个示例中,图像175可以表示一系列帧中的单个帧,可以对该一系列帧进行连续分析以追踪用户的眼睛1702。此外,可以在一段时间内对瞳孔178和/或闪烁1710进行追踪,以确定用户的注视。

137.在一个示例中,眼动追踪子系统1700可以被配置为识别和测量用户的瞳孔间距离(inter-pupillary distance,ipd)。在一些示例中,眼动追踪子系统1700可以在用户正佩戴着人工现实系统时,对用户的ipd进行测量和/或计算。在这些示例中,眼动追踪子系统1700可以检测用户的眼睛的位置,并且可以使用该信息来计算用户的ipd。

138.如所提到的,本文所公开的眼动追踪系统或眼动追踪子系统可以以各种方式追踪用户的眼睛位置和/或眼动。在一个示例中,一个或多个光源和/或光学传感器可以采集用户眼睛的图像。然后,眼动追踪子系统可以使用所采集的信息来确定用户的瞳孔间距离、眼间距、和/或每只眼睛的3d位置(例如,以用于失真调整目的),所采集的信息包括每只眼睛的扭转和转动的幅度(即,翻转、上下运动和左右运动)和/或注视方向。在一个示例中,红外光可以由眼动追踪子系统发射并从每只眼睛反射。所反射的光可以由光学传感器接收或检测,并且可以对所反射的光进行分析,以从由每只眼睛反射的红外光的变化中提取眼睛转动数据。

139.眼动追踪子系统可以使用各种不同方法中的任何一种来追踪用户的双眼。例如,光源(例如,红外发光二极管)可以将点图案发射到用户的每只眼睛上。然后,眼动追踪子系统可以(例如,通过耦接到人工现实系统的光学传感器)检测从用户的每只眼睛对该点图案的反射,并对该反射进行分析以识别用户的每个瞳孔的位置。因此,眼动追踪子系统可以追踪每只眼睛的多达六个自由度(即,3d位置、翻转、上下运动和左右运动),并且可以对来自用户的双眼的所追踪的量的至少一个子集进行组合,以估计注视点(即,3d位置或用户正在观看的虚拟场景中的位置)和/或ipd。

140.在一些情况下,当用户的眼睛移动看向不同方向时,用户的瞳孔和显示器之间的距离可能会改变。瞳孔和显示器之间、在观看方向改变时变化的距离可以被称为“瞳孔游移(pupil swim)”,并且由于随着瞳孔和显示器之间的距离改变而使光聚焦在不同的位置,上述变化的距离会造成用户可感知的失真。因此,测量相对于显示器在不同眼睛位置和瞳孔距离处的失真、并针对不同位置和距离生成失真校正可以允许通过以下方式来减少由瞳孔游移引起的失真:追踪用户眼睛的3d位置,并及时在给定点处应用与用户的每只眼睛的3d位置相对应的失真校正。因此,知道用户的每只眼睛的3d位置可以允许通过对每个3d眼睛位置应用失真校正,来减少因眼睛的瞳孔和显示器之间的距离的变化而引起的失真。此外,如上所提及的,知道用户每只眼睛的位置还可以使眼动追踪子系统能够对用户的ipd进行自动调整。

141.在一些示例中,显示子系统可以包括各种附加子系统,这些附加子系统可以结合本文所描述的眼动追踪子系统来工作。例如,显示子系统可以包括变焦子系统、场景渲染模块、和/或辐辏处理模块。变焦子系统可以使左显示元件和右显示元件改变显示设备的焦

距。在一个示例中,变焦子系统可以通过移动显示器、光学器件、或这两者,来在物理上改变显示器与光学器件(该显示器通过该光学器件被观看)之间的距离。此外,相对于彼此移动或平移两个透镜也可以用于改变显示器的焦距。因此,变焦子系统可以包括致动器或马达,该致动器或马达对显示器和/或光学器件进行移动以改变它们之间的距离。变焦子系统可以与显示子系统分开或集成到显示子系统中。变焦子系统还可以集成到其致动子系统和/或本文所描述的眼动追踪子系统中,或与其致动子系统和/或本文所描述的眼动追踪子系统分开。

142.在一个示例中,显示子系统可以包括辐辏处理模块,该辐辏处理模块被配置为基于由眼动追踪子系统确定的注视点和/或视线(gaze line)的估计交汇点,来确定用户的注视的辐辏深度。辐辏可以指双眼同时向相对的方向移动或转动以维持双眼单视,这可以由人眼自然地且自动地执行。因此,用户的双眼会聚的位置是用户正在观看的位置,并且通常也是用户的双眼聚焦的位置。例如,辐辏处理模块可以对视线进行三角测量,以估计距用户的、与视线的交汇点相关联的距离或深度。然后,与视线的交汇点相关联的深度可以用作调焦距离的近似值,其可识别用户眼睛所指向的、距用户的距离。因此,辐辏距离可以允许确定用户的双眼应该聚焦的位置、以及距用户的双眼的深度(用户的双眼在该深度处聚焦),从而提供用于对虚拟场景进行渲染调整的信息(例如,对象或焦平面)。

143.辐辏处理模块可以与本文所描述的眼动追踪子系统配合以对显示子系统进行调整,以考虑用户的辐辏深度。在用户聚焦在远处的东西上时,用户的瞳孔可能分开得比用户聚焦在近处的东西时稍微远一些。眼动追踪子系统可以获取关于用户的辐辏或聚焦深度的信息,并且可以在用户的双眼聚焦或会聚在近处的东西上时将显示子系统调整为更靠近,并且在用户的双眼聚焦或会聚在远处的东西上时将显示子系统调整为更远离。

144.由上述眼动追踪子系统生成的眼动追踪信息还可以例如用于修改如何呈现不同的计算机生成图像的各个方面。例如,显示子系统可以被配置为基于由眼动追踪子系统生成的信息来修改如何呈现计算机生成图像的至少一个方面。例如,可以基于用户的眼动来修改计算机生成图像,使得如果用户正在向上看,则可以在屏幕上将计算机生成图像向上移动。类似地,如果用户正在向一侧看或向下看,则可以在屏幕上将计算机生成图像向一侧移动或向下移动。如果用户闭眼,则可以暂停计算机生成图像或从显示器中移除该计算机生成图像,并且一旦用户再次睁开眼睛,就会恢复该计算机生成图像。

145.可以将上述眼动追踪子系统以各种方式结合到本文所描述的各种人工现实系统中的一个或多个人工现实系统中。例如,可以将系统1600和/或眼动追踪子系统1700的各个部件中的一个或多个部件结合到图11中的增强现实系统1100和/或图12中的虚拟现实系统1200中,以使这些系统能够执行各种眼动追踪任务(包括本文所描述的眼动追踪操作中的一个或多个眼动追踪操作)。

146.图18a示出了被配置为作为可穿戴系统1800而被佩戴在用户的下臂或手腕上的示例性人机接口(本文也称为emg控制接口)。在该示例中,可穿戴系统1800可以包括十六个神经肌肉传感器1810(例如,emg传感器),该十六个神经肌肉传感器围绕弹性带1820而周向地布置,该弹性带的内表面1830被配置为接触用户的皮肤。然而,可以使用任何合适数量的神经肌肉传感器。神经肌肉传感器的数量和布置可以取决于可穿戴设备所用于的特定应用。例如,可穿戴臂带或腕带可以用于生成控制信息,该控制信息用于控制增强现实系统、机器

人,用于控制载具,用于滚动文本,用于控制虚拟化身或用于任何其他合适的控制任务。如图所示,可以使用结合到无线设备中的柔性电子器件将这些传感器耦接在一起。图18b示出了从图18a中所示的可穿戴设备的多个传感器中的一个传感器的横截面图。在一些示例中,可选地,可以使用硬件信号处理电路来处理多个传感部件中的一个或多个传感部件的输出(例如,以执行放大、滤波和/或整流)。在其他示例中,可以在软件中执行对多个传感部件的输出的至少一些信号处理。因此,对由传感器采样的信号的信号处理可以在硬件、软件中执行,或通过硬件和软件的任何合适组合来执行,本文中所描述的技术的各方面在此不受限制。以下参考图19a和图19b更详细地论述用于处理来自传感器1810的记录数据的信号处理链的非限制性示例。

147.图19a和图19b示出了可穿戴系统的具有多个emg传感器的内部部件的示例性示意图。如图所示,可穿戴系统可以包括可穿戴部分1910(图19a)和适配器(dongle)部分1920(图19b),该适配器部分(例如,通过蓝牙或另一合适的无线通信技术)与该可穿戴部分1910通信。如图19a所示,可穿戴部分1910可以包括多个皮肤接触电极1911,这些皮肤接触电极的示例结合图18a和图18b进行了描述。可以将该多个皮肤接触电极1911的输出提供至模拟前端1930,该模拟前端可以被配置为对所记录的信号执行模拟处理(例如,放大、降噪、滤波等)。然后,可以将处理后的模拟信号提供至模数转换器1932,该模数转换器可以将模拟信号转换成数字信号,该数字信号可以由一个或多个计算机处理器处理。如图19a所示,根据一些示例可使用的计算机处理器的示例为微控制器(microcontroller,mcu)1934。如图所示,mcu 1934还可以包括来自其他传感器(例如,imu传感器1940)的输入、以及来自电源和电池模块1942的输入。可以将由mcu 1934执行的处理的输出提供至天线1950,以用于传输到图19b中所示的适配器部分1920。

148.适配器部分1920可以包括天线1952,该天线可以被配置为与作为可穿戴部分1910的一部分而被包括的天线1950通信。天线1950和天线1952之间的通信可以使用任何合适的无线技术和协议进行,该无线技术和协议的非限制性示例包括射频信号传递(radiofrequency signaling)和蓝牙。如图所示,可将由适配器部分1920的天线1952接收的信号提供至主计算机,以用于进一步的处理、显示,和/或用于实现对一个或多个特定物理对象、或一个或多个特定虚拟对象的控制。

149.尽管在具有多个emg传感器的接口的上下文中,对参考图18a和图18b、以及图19a和图19b所提供的示例进行了论述,但本文所描述的用于减少电磁干扰的技术也可以在具有其他类型的传感器的可穿戴接口中实现,这些其他类型的传感器包括但不限于:肌动图(mechanomyography,mmg)传感器、声肌图(sonomyography,smg)传感器和电阻抗断层成像(electrical impedance tomography,eit)传感器。本文所描述的用于减少电磁干扰的技术也可以在这样的可穿戴接口中实现:所述可穿戴接口通过导线和电缆(例如,通用串行总线(usb)电缆、光纤电缆等)与计算机主机通信。

150.图20示意性地示出了根据一些示例的生物信号传感系统2000的多个部件。系统2000包括一对电极2010(例如,一对干表面电极),该一对电极被配置为记录或测量由用户2002的身体产生的生物信号(例如,眼电图(eog)信号、肌电图(emg)信号、表面肌电图(surface electromyography,semg)信号、脑电图(electroencephalography,eeg)信号、心电图(electrocardiography,ecg)信号等)(例如,以用于电生理监测或刺激)。在一些示例

中,两个电极2010都可以是被配置为接触用户的皮肤的接触电极。在其他示例中,两个电极2010都可以是被配置为不接触用户的皮肤的非接触电极。替代地,两个电极2010中的一个电极可以是被配置为接触用户的皮肤的接触电极,而两个电极2010中的另一个电极可以是被配置为不接触用户的皮肤的非接触电极。在一些示例中,两个电极2010可以作为如下可穿戴设备的一部分来布置:该可穿戴设备被配置为佩戴在用户的身体部位上或用户的身体部位周围。例如,在一个非限制性示例中,包括电极2010的多个电极可以围绕可调节带和/或弹性带(例如,腕带或臂带)而周向地布置,该可调节带和/或弹性带被配置为佩戴在用户的手腕或手臂上(例如,如图18a和图18b所示)。附加地或替代地,电极2010中的至少一些电极可以布置在如下的可穿戴贴片上:该可穿戴贴片被配置为固定到用户2002的身体的一部分或者被置为与该用户的身体的一部分接触。在一些示例中,电极可以是微创性的,并且可以包括被放置在或穿过用户的全部或部分皮肤或真皮的一个或多个导电部件。应当理解,可以使用任何合适数量的电极,并且电极的数量和布置可以取决于使用设备的特定应用。

151.由电极2010测量或记录的生物信号(例如,生物电位信号)可以很小,并且可能需要对由电极2010记录的生物信号进行放大。如图20所示,电极2010可以耦接到放大电路2011,该放大电路被配置为对由电极2010传导的生物信号进行放大。放大电路2011可以包括任何合适的放大器。合适的放大器的示例可以包括运算放大器、放大两个输入电压之间的差值的差分放大器、仪器放大器(例如,具有输入缓冲放大器的差分放大器)、单端放大器和/或能够放大生物信号的任何其他合适的放大器。

152.如图20所示,可以将放大电路2011的输出提供至模数转换器(analog-to-digital converter,adc)电路2014,该模数转换器电路可以将经放大的生物信号转换成数字信号以供微处理器2016进行进一步处理。在一些示例中,微处理器2016可以(例如,通过将生物信号转换或变换为对用户2002的身体中的一个或多个骨骼结构的空间关系的估计、和/或由用户2002的身体中的至少一个骨骼结构施加的力的估计)对数字信号进行处理以增强远程或虚拟社交体验。微处理器2016可以由一个或多个硬件处理器实现。在一些示例中,电极2010、放大电路2011、adc电路2014和/或微处理器2016可以表示单个生物信号传感器中的一些或全部。从微处理器2016输出的处理后的信号可以由主机2020来解释,该主机的示例包括但不限于:台式计算机、膝上型计算机、智能手表、智能手机、头戴式显示设备、或任何其他计算设备。在一些实施方式中,主机2020可以被配置为至少部分地基于对从微处理器2016输出的信号进行分析,来输出一个或多个用于控制物理或虚拟设备或对象的控制信号。如图所示,生物信号传感系统2000可以包括附加的传感器2018,该附加的传感器可以被配置为记录除生物信号信息以外的关于用户状态的信息类型。例如,传感器2018可以包括:被配置为测量皮肤温度/电极温度的温度传感器、被配置为测量运动信息(例如,转动和加速度)的惯性测量单元(imu)传感器、湿度传感器、以及被配置为提供关于用户和/或用户环境的信息的其他生化传感器。

153.如上所详述的,本文所描述和/或所示出的计算设备和系统广泛地表示能够执行计算机可读指令(例如,包含在本文所描述的多个模块中的那些指令)的、任何类型或形式的计算设备或系统。在一个或多个计算设备的最基本配置中,该一个或多个计算设备均可以包括至少一个存储设备和至少一个物理处理器。

154.在一些示例中,术语“存储设备”概括地指能够存储数据和/或计算机可读指令的

任何类型或形式的易失性或非易失性存储设备或介质。在一个示例中,存储设备可以存储、加载和/或维护本文所描述的各模块中的一个或多个模块。存储设备的示例包括但不限于,随机存取存储器(ram)、只读存储器(rom)、闪存、硬盘驱动器(hdd)、固态驱动器(ssd)、光盘驱动器、高速缓冲存储器、以上中的一个或多个的变型或组合、或任何其他合适的存储器。

155.在一些示例中,术语“物理处理器”概括地指能够解释和/或执行计算机可读指令的任何类型或形式的硬件实现的处理单元。在一个示例中,物理处理器可以访问和/或修改存储在上述存储设备中的一个或多个模块。物理处理器的示例包括但不限于,微处理器、微控制器、中央处理单元(cpu)、实现软核处理器的现场可编程门阵列(fpga)、专用集成电路(asic)、以上中的一个或多个中的部分、以上中的一个或多个的变型或组合、或任何其他合适的物理处理器。

156.尽管本文所描述和/或所示出的各模块被示出为单独的元件,但是这些模块可以表示单个模块中的部分或单个应用中的部分。另外,在某些示例中,这些模块中的一个或多个模块可以表示一个或多个软件应用或程序,该一个或多个软件应用或程序在被计算设备执行时可以使该计算设备执行一个或多个任务。例如,本文描述和/或所示出的各模块中的一个或多个模块可以表示这样的模块:所述模块存储在本文所描述和/或所示出的计算设备或系统中的一个或多个上,并且被配置为在本文所描述和/或所示出的计算设备或系统中的一个或多个上运行。这些模块中的一个或多个模块还可以表示被配置为执行一个或多个任务的一个或多个专用计算机的全部或部分。

157.此外,本文所描述的各模块中的一个或多个模块可以将数据、物理设备和/或物理设备的表示从一种形式转换为另一种形式。例如,本文所陈述的各模块中的一个或多个模块可以接收待变换的生物信号(例如,包含眼动追踪数据的生物信号),将该生物信号变换为向用户的认知状态转换或从用户的认知状态转换的预测,将变换结果输出到智能助益子系统,和/或使用变换结果以执行一个或多个辅助动作和/或干预,该一个或多个辅助动作和/或干预减少了与认知状态相关联的认知负担。附加地或替代地,本文所陈述的各模块中的一个或多个模块可以通过在计算设备上执行、在计算设备上存储数据、和/或以其他方式与计算设备交互,来将物理计算设备的处理器、易失性存储器、非易失性存储器、和/或任何其他部分从一种形式转换成另一种形式。

158.在一些示例中,术语“计算机可读介质”概括地是指能够存储或承载计算机可读指令的任何形式的设备、载体或介质。计算机可读介质的示例包括但不限于,传输型介质(例如,载波)、和非暂态型介质,所述非暂态型介质例如为磁存储介质(例如,硬盘驱动器、磁带驱动器和软盘)、光存储介质(例如,光盘(compact disk,cd)、数字视频光盘(digital video disk,dvd)和蓝光光盘)、电子存储介质(例如,固态驱动器和闪存介质)、以及其他分发系统。

159.本文所描述和/或所示出的工艺参数和步骤顺序仅以示例的方式给出,并且可以根据需要改变。例如,尽管本文所示出和/或所描述的步骤可能是以特定顺序显示或论述的,但这些步骤不一定需要按照所示出或所论述的顺序来执行。本文所描述和/或所示出的各种示例性方法也可以省略本文所描述或所示出的各步骤中的一个或多个步骤,或者可以包括除了所公开的那些步骤之外的附加步骤。

160.已提供之前的描述来使本领域技术人员能够最好地利用本文所公开的示例性实

施例的各个方面。该示例性描述并不旨在是详尽的或被限制为所公开的任何精确形式。在不脱离本公开的范围的情况下,许多修改和变型是可能的。本文所公开的示例在所有方面都应被认为是说明性的而不是限制性的。在确定本公开的范围时,应当参考所附的任何权利要求及其等同物。

161.除非另有说明,否则如说明书和权利要求书中所使用的术语“连接到”和“耦接到”(及其派生词)将被解释为允许直接连接和间接连接(即,通过其他元件或部件)这两者。此外,如说明书和权利要求书中所使用的术语“一个(a)”或“一个(an)”将被解释为表示“中的至少一个”。最后,为了便于使用,如说明书和权利要求书中所使用的术语“包括(including)”和“具有”(及其派生词)与词语“包括(comprising)”是可互换的,并且具有与词语“包括(comprising)”相同的含义。

当前第1页1

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!